ニュース

医学分野に対する「ChatGPT」の正答率は文献数により向上する:医療技術ニュース

横浜市立大学は、OpenAIの「ChatGPT」に、医学に関する質問をする際の注意点を科学的に検証した。ChatGPTの性能は、各医学分野における情報量の影響を受けている可能性が示された。

横浜市立大学は2023年11月15日、OpenAIの「ChatGPT」に、医学に関する質問をする際の注意点を科学的に検証したと発表した。ChatGPTの性能は、各医学分野の情報量の影響を受けている可能性があり、新薬や新興感染症など情報量が少ない分野を質問する際は、回答が正しいか注意する必要性が示唆された。

研究では、ChatGPTに日本の医師国家試験3年分の問題を出題。旧モデルの「GPT-3.5」と最新モデルの「GPT-4」を使用し、正答率と回答の一貫性を集計したところ、GPT-3.5に比べてGPT-4は性能が大幅に向上していた。正答率は、GPT-3.5が56.4%、GPT-4は81.0%で、回答の一貫性は56.5%から88.8%に向上していた。

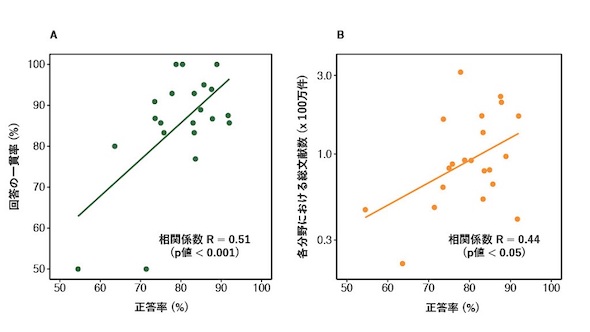

次に、試験問題を出題形式や出題内容に応じて分類し、正答率に関連する因子を検証した。各分野における正答率は、その分野のこれまで出版された文献数と有意な関連を示し、文献数が少ない領域では正答率が相対的に低かった。

同一問題を連続して出題した場合では、回答内容の一致率と正答率は有意な関連を示した。複数の答えを同時に選ばせる多肢選択問題や計算を必要とする問題では、単肢選択問題に比べて不正答となる可能性が高かった。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

カテキンとフッ化物の相乗作用でむし歯予防効果が向上

カテキンとフッ化物の相乗作用でむし歯予防効果が向上

東北大学は、カテキンとフッ化物を併用することで、口腔内微生物による酸の産生を効率良く抑制できることを明らかにした。カテキンとフッ化物の相乗作用を利用した、新しいむし歯予防法の開発が期待される。 生体の撮影も可能な、動的条件下でのX線CT撮影技術を開発

生体の撮影も可能な、動的条件下でのX線CT撮影技術を開発

早稲田大学は、ストロボ効果を利用した動的条件下でのX線CT撮影技術を開発した。心臓のように繰り返し変形するものであれば、生体の動的X線撮影も可能になる技術だ。 残存しているわずかな筋の動作でメタバースに操作命令できる技術を開発

残存しているわずかな筋の動作でメタバースに操作命令できる技術を開発

NTTは、四肢など肢体が重度に不自由な人のわずかな筋の動作をメタバースへの操作命令につなげる入力インタフェースを開発した。自分の意思を伝えるための身体拡張技術として、表面筋電信号入力を利用できるようになる。 医療機関向けにIoMT一元管理支援サービスの提供を開始

医療機関向けにIoMT一元管理支援サービスの提供を開始

富士フイルムビジネスイノベーションは、医療機関向けに「IT Expert Services IoMTデバイスマネジメントサービス」の提供を開始した。医療機関内のIT機器を可視化し、セキュリティリスクを一元管理する。 紫外線や熱が皮膚のバリア機能を低下させる一因を解明

紫外線や熱が皮膚のバリア機能を低下させる一因を解明

富士フイルムは、紫外線や熱で酸化した皮脂である過酸化脂質と分解物が、皮膚のバリア機能を低下させる一因を解明した。セラミドなどの産生に重要な遺伝子や、バリア機能維持関連因子の遺伝子発現量を減少させる。 造影剤を使わないCT画像から膵臓がんの検出を支援する技術を開発

造影剤を使わないCT画像から膵臓がんの検出を支援する技術を開発

富士フイルムと神戸大学は、AI技術を活用して、非造影CT画像から膵臓がんが疑われる所見の検出を支援する技術を開発した。人間ドックなどでの活用により、膵臓がんの早期発見につながることが期待される。