演算量を90%減、エッジで画像生成・認識できるAIを三菱電機が開発:人工知能ニュース(2/2 ページ)

三菱電機は2019年1月31日、従来手法から演算量とメモリ量を約10分の1に抑えた画像生成用ディープニューラルネットワーク構築技術を開発したと発表した。画像生成や画像内の物体認識を組み込みデバイスやエッジ上で動作させることを狙う技術となる。

ラズパイにも「実装できるかもしれない」

一方で、GANの生成ネットワークは隠れ層が複数あるディープニューラルネットワークであるため、大量の画像を高速に生成するには高性能なコンピュータを必要とする。三菱電機は生成ネットワークのモデル構造を独自手法で軽量化し、高速な画像生成に必要な演算量とメモリ量を約10分の1に削減することに成功した。

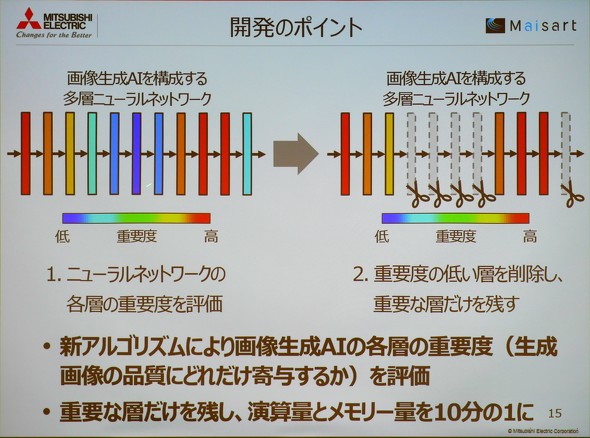

三菱電機が開発した独自手法のポイントは生成画像の品質にあまり寄与しない隠れ層を間引くことだ。同手法では、まず従来通りにGANによって生成ネットワークと識別ネットワークを学習させる。その後、識別ネットワークに生成ネットワークの各隠れ層における重要度を評価するアルゴリズムを導入し、生成ネットワーク内で重要度の低い隠れ層を削除、生成画像の品質に重要な層のみ残して再学習を行う。

この手法はアプリケーションの精度に寄与しないノードを刈り取るPruning(剪定)とは異なり、隠れ層ごと間引きネットワーク構造を変化させることが特徴。これにより間引く前のネットワークから約90%のノードを削減するという。また、隠れ層を間引いた生成ネットワークの画像品質は「主観評価だが(間引く前と)同等」(杉本氏)とし、同手法による画像品質への大きな影響はないとの認識を示した。この理由について、杉本氏は「隠れ層の数は変わるが、再学習によってノードの重みが変わることでカバーしている」と説明する。

同社はGANの生成ネットワークを用いて自動車の走行画像を生成するデモを実施。従来技術と今回提案した技術による生成ネットワークの性能を比較した。生成ネットワークはIntel Core i7-7500U、16GBのメモリを搭載したノートPC上で動作させた。

従来技術では1枚当たり約3〜5秒の処理時間を必要としていたが、同技術では処理時間が約0.3秒とスムーズに走行画像が出力されていた。同技術を用いた生成ネットワークは「解像度などの条件にもよるが、組み込み系CPUでも動作する可能性がある」(杉本氏)。同社担当者はRaspberry Piクラスの性能でも「実装できるかもしれない」と話す。

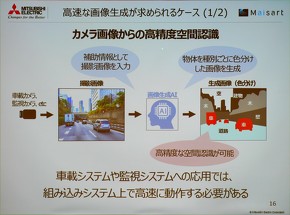

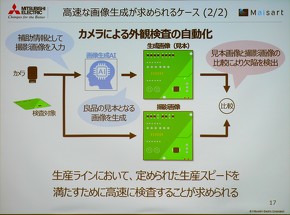

同社は同技術の用途として学習用データセット準備の他に、カメラ画像を入力とした自動運転や外観検査、監視システムへの応用を見込む。いずれの用途も車両や装置へ搭載するために組み込み機器のサイズや性能が限られており、同技術のニーズは高いとみられる。実用化の時期に関しては「GAN自体が新しい技術。いつまでに、ということはこれから検討したい」(杉本氏)としている。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

“プロセッサ”を開発する東芝メモリ、その技術と狙い

“プロセッサ”を開発する東芝メモリ、その技術と狙い

東芝メモリがプロセッサの開発を発表した。現業から離れているように見えるプロセッサの開発を通じて東芝メモリは何を目指すのか。今回発表された技術の概要と開発の狙いを聞いた。 低コストFPGAで深層学習、コア技術をオープンソース化したベンチャーの狙い

低コストFPGAで深層学習、コア技術をオープンソース化したベンチャーの狙い

LeapMindは2018年10月19日、組み込み向けFPGA上でディープラーニングを動作させるソフトウェアスタックをオープンソースで公開した。同社が今まで強みとしてきた技術が、誰でも利用もできるようになった。同社CTO(最高技術責任者)を務める徳永拓之氏に、blueoilとはどのようなもので、何が実現できるのか。そして、オープンソース化した狙いなどを聞いた。 組み込みAIは必要不可欠な技術へ、推論に加えて学習も視野に

組み込みAIは必要不可欠な技術へ、推論に加えて学習も視野に

2017年初時点では芽吹きつつあった程度の組み込みAI。今や大きな幹にまで成長しつつあり、2019年からは、組み込み機器を開発する上で組み込みAIは当たり前の存在になっていきそうだ。 深層学習AIをエッジで動かす、東芝と理研がスパース化現象でパラメータ8割削減

深層学習AIをエッジで動かす、東芝と理研がスパース化現象でパラメータ8割削減

東芝と理化学研究所が、深層学習(ディープラーニング)によって得られるAI(人工知能)である「深層ニューラルネットワーク(DNN)」のコンパクト化技術を開発。DNNの性能を維持したままで、学習した結果であるパラメータを80%削減できる。 三菱電機の「コンパクトな人工知能」、FPGAへの実装も可能に

三菱電機の「コンパクトな人工知能」、FPGAへの実装も可能に

三菱電機は小規模なFPGAにも実装できる「コンパクトなハードウェアAI」を発表。深層学習などによって得た推論アルゴリズムについて、従来と比べて処理速度を10倍、もしくはFPGAの回路規模を10分の1にすることができるという。 PFNが深層学習プロセッサを開発した理由は「世界の先を行くため」

PFNが深層学習プロセッサを開発した理由は「世界の先を行くため」

Preferred Networks(PFN)は2018年12月12日、ディープラーニングに特化したプロセッサ「MN-Core(エムエヌ・コア)」を発表した。同プロセッサは学習の高速化を目的とし、行列の積和演算に最適化されたものとなる。FP16演算実行時の電力性能は世界最高クラス(同社調べ)の1TFLOPS/Wを達成した。