深層学習AIをエッジで動かす、東芝と理研がスパース化現象でパラメータ8割削減:人工知能ニュース

東芝と理化学研究所が、深層学習(ディープラーニング)によって得られるAI(人工知能)である「深層ニューラルネットワーク(DNN)」のコンパクト化技術を開発。DNNの性能を維持したままで、学習した結果であるパラメータを80%削減できる。

東芝と理化学研究所(以下、理研)は2018年12月17日、深層学習(ディープラーニング)によって得られるAI(人工知能)である「深層ニューラルネットワーク(DNN:Deep Neural Networks)」のコンパクト化技術を開発したと発表した。DNNの性能を維持したままで、学習した結果であるパラメータを80%削減できる。これにより、エッジデバイス上で高精度な音声や画像などの認識処理を動作させられるようになるという。自動運転向け画像認識システムなど組み込み機器やエッジデバイスにおける高度なDNNの活用に向け、2020〜2021年ごろをめどに実用化を目指す。

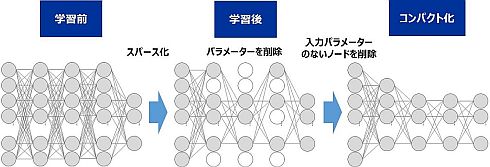

東芝は、深層学習を行う際に、DNNの一部のパラメータが自動的にゼロ近傍に収束する「スパース化現象」を発見し、理研と共同でその発生原理を解明した。学習後にゼロとなったパラメータは認識結果に影響しないことから、学習後にそれらのパラメータを削除することでDNNのコンパクト化を実現した。

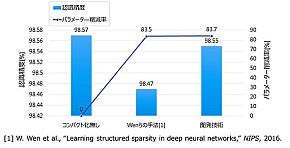

公開データセットを用いた実験では、開発したDNNのコンパクト化技術が、従来技術よりも認識精度の低下を抑えつつ、約80%のパラメータを削減できることを確認した。さらに、パラメータ削減率を調整し、DNNのサイズを柔軟に変更できる方法を開発した。

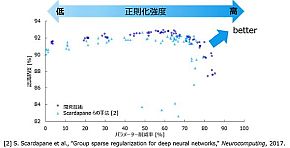

(左)手書き数字画像10クラスの「MNIST」という画像データセットにおいて、4層の全結合ネットワークを用いた実験の結果。コンパクト化なしのネットワークから認識精度0.02%の低下で、パラメータ数を83.7%削減可能であることを確認した。(右)一般物体認識のベンチマークとしてよく使われている「CIFAR-10」という画像データセットにおいて、16層の畳み込みニューラルネットワークを用いた実験の結果。認識精度の低下が約1%以内の範囲では、正則化強度を変更することでネットワークのパラメータ数を30〜70%程度削減でき、DNNのサイズを柔軟に変更できることを確認した(クリックで拡大) 出典:東芝

(左)手書き数字画像10クラスの「MNIST」という画像データセットにおいて、4層の全結合ネットワークを用いた実験の結果。コンパクト化なしのネットワークから認識精度0.02%の低下で、パラメータ数を83.7%削減可能であることを確認した。(右)一般物体認識のベンチマークとしてよく使われている「CIFAR-10」という画像データセットにおいて、16層の畳み込みニューラルネットワークを用いた実験の結果。認識精度の低下が約1%以内の範囲では、正則化強度を変更することでネットワークのパラメータ数を30〜70%程度削減でき、DNNのサイズを柔軟に変更できることを確認した(クリックで拡大) 出典:東芝スパース化現象が起こる学習条件は3つある。1つ目は、DNNの表現力を高めるために一般的に導入される非線形関数ReLU(Rectified linear unit)を活性化関数として用いる場合だ。2つ目は、学習データへの過剰適合を抑制するために導入される正則化関数(L2 Regularization function)として、パラメータの2乗ノルム(ベクトルの長さ)を用いる場合である。そして3つ目は、パラメータ最適化手法の1つで確率的勾配降下法と呼ばれる「Adam(Adaptive moment estimation)」を用いる場合になる。

これらは一般的に用いられる学習条件だが、スパース化現象を発生させることは今まで知られていなかった。スパース現象を利用することで、学習後の不要なパラメータの削除により、従来に比べて手軽にDNNをコンパクト化できる。

ニューラルネットワークは、人間の脳の生物学的な仕組みを模したAIの計算モデルあり、近年ではこのネットワークを多層構造化したDNNを用いることで、より複雑で大規模な認識処理を行うことが可能になりつつある。ただし、高い性能を実現するDNNは、大規模で複雑化する傾向があり、演算能力やメモリ量が限られたエッジデバイス上で動作させることが困難だ。DNNをコンパクト化する技術が複数の研究機関から提案されているものの、特別な処理や追加学習が必要となるなど、手間がかかることが課題になっている。

スパース化現象は一般的に用いられる学習条件によって起こることから、他の技術よりも容易にDNNをコンパクト化できる可能性がある。

なお、開発技術は東芝と理研が2017年4月に設立した「理研AIP−東芝連携センター」の成果になる。両者は同技術の詳細について、2018年12月17〜20日に米国フロリダ州で開催される機械学習の国際会議である「IEEE International Conference on Machine Learning and Applications(ICMLA) 2018」で発表する予定だ。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

世界を変えるAI技術「ディープラーニング」が製造業にもたらすインパクト

世界を変えるAI技術「ディープラーニング」が製造業にもたらすインパクト

人工知能やディープラーニングといった言葉が注目を集めていますが、それはITの世界だけにとどまるものではなく、製造業においても導入・検討されています。製造業にとって人工知能やディープラーニングがどのようなインパクトをもたらすか、解説します。 機械学習はどうやって使うのか――意外と地道な積み重ね

機械学習はどうやって使うのか――意外と地道な積み重ね

前編では、AI(人工知能)と機械学習、ディープラーニングといった用語の説明から、AIを実現する技術の1つである機械学習が製造業を中心とした産業界にも徐々に使われ始めている話をした。後編では、機械学習を使ったデータ分析と予測モデル作成について説明する。 AIと機械学習とディープラーニングは何が違うのか

AIと機械学習とディープラーニングは何が違うのか

技術開発の進展により加速度的に進化しているAI(人工知能)。このAIという言葉とともに語られているのが、機械学習やディープラーニングだ。AIと機械学習、そしてディープラーニングの違いとは何なのか。 “プロセッサ”を開発する東芝メモリ、その技術と狙い

“プロセッサ”を開発する東芝メモリ、その技術と狙い

東芝メモリがプロセッサの開発を発表した。現業から離れているように見えるプロセッサの開発を通じて東芝メモリは何を目指すのか。今回発表された技術の概要と開発の狙いを聞いた。 三菱電機の「コンパクトな人工知能」、FPGAへの実装も可能に

三菱電機の「コンパクトな人工知能」、FPGAへの実装も可能に

三菱電機は小規模なFPGAにも実装できる「コンパクトなハードウェアAI」を発表。深層学習などによって得た推論アルゴリズムについて、従来と比べて処理速度を10倍、もしくはFPGAの回路規模を10分の1にすることができるという。 「コンパクトな人工知能」実現へ、組み込み機器でディープラーニング

「コンパクトな人工知能」実現へ、組み込み機器でディープラーニング

三菱電機がディープラーニングを組み込み機器単体でも実用可能なものとする手法を開発。自動車や産業用ロボット、監視カメラなどへの「人工知能」搭載を進める。