組み込みAIは必要不可欠な技術へ、推論に加えて学習も視野に:MONOist 2019年展望(3/4 ページ)

2017年初時点では芽吹きつつあった程度の組み込みAI。今や大きな幹にまで成長しつつあり、2019年からは、組み込み機器を開発する上で組み込みAIは当たり前の存在になっていきそうだ。

AIチップも組み込み分野へ展開を拡大

AI技術で今最も注目を集めているのは、AIの処理に特化したASICである「AIチップ」の開発だろう。CPU、GPU、FPGAは用途を特定しない汎用デバイスであるため、AI処理に用いると何らかのオーバーヘッドが生じる。しかし、AIの処理という特定の用途に特化したAIチップであれば、そういったオーバーヘッドが発生しにくい。

その先駆けとなるのが、グーグルが2013年に開発を始めた「TPU」だ。第1世代のTPUは推論実行に特化していたが、第2世代では学習と推論の両方に対応。現在は、このTPUの処理能力をクラウドサービスの「Cloud TPU」として提供している※)。

※)関連記事:グーグルの深層学習プロセッサ「TPU」が「AIを、全ての人に」を実現する

グーグルの他にも、クラウド/サーバ向けにAIチップを開発する例は増え始めている。AWSの「AWS Inferentia」、Preferred Networks(PFN)の「MN-Core」などがその事例になる。インテルも、2016年に買収したNervana Systemsの技術をベースにしたAIチップを開発中だ。同社はCES 2019で10nm世代の製品群をはじめ新製品の投入スケジュールをアナウンスしており、NervanaベースのAIチップについても、推論向けの「NNP-I」、学習向けの「Spring Crest」を2019年内に投入するとしている。

これらのクラウド/サーバ向けAIチップは組み込み機器を開発するエンジニアにとって、直接活用できる技術とはいえない。しかし、組み込みAIの分野でもAIチップの開発は加速している。

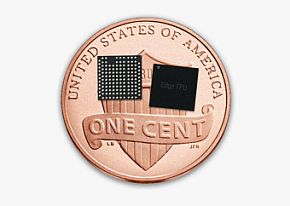

クラウド/サーバ向けにTPUを開発したグーグルは、組み込み機器などのエッジデバイス上で利用可能なAIチップ「Edge TPU」の提供をアナウンスしている。グーグルの機械学習フレームワークであるTensorFlowの軽量版「TesorFlow Lite」による機械学習モデルの推論実行に特化しており、そのチップサイズは1セント硬貨の上に4枚収まるほどの小ささだ。まさに“組み込みAIチップ”といえるだろう※)。

※)関連記事:グーグルがエッジデバイスにもAIチップを展開、推論実行に特化した「Edge TPU」

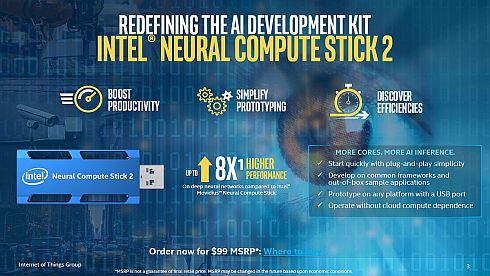

インテルは、Nervana Systemsと同じく2016年に買収したMovidiusの画像認識プロセッサを組み込みAI分野で展開している。2018年11月に発表したUSBスティック型組み込みAI(人工知能)デバイスの最新モデル「Intel Neural Compute Stick 2(NCS 2)」は、次世代の画像認識プロセッサである「Myriad X」を搭載している※)。

※)関連記事:インテルのUSBスティック型組み込みAIデバイス、最新版の動作デモが公開中

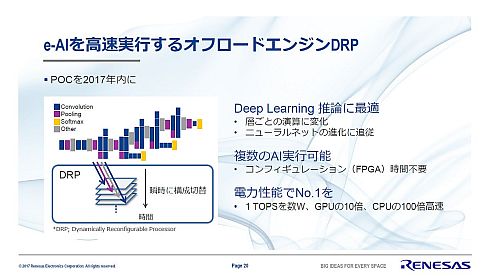

「マイコンにもAIを」というスローガンのもと、組み込みAI技術「e-AI」を展開するルネサス エレクトロニクスは、動的に再構成が可能なプロセッサ技術「DRP(Dynamically Reconfigurable Processor)」の搭載により「AI処理性能が10倍になった」(同社)とする製品の投入を始めている。第1弾製品の「RZ/A2M」は、メインCPUが「Cortex-A9」であるためデバイス種としてはマイクロプロセッサとなっているが、回路技術としてのDRPはAI処理に特化していると言っていい※)。

※)関連記事:ルネサスの組み込みAIの性能が10倍に、独自開発の「DRP」で実現

自動車部品メーカーではあるものの半導体の設計開発を続けてきたデンソーは、自動運転に最適なプロセッサ「DFP(データフロープロセッサ)」を開発中だ。子会社のエヌエスアイテクスで開発を進めており、「第11回オートモーティブワールド」(2019年1月16〜18日、東京ビッグサイト)ではテストチップとテストボードを展示するという※)。

Copyright © ITmedia, Inc. All Rights Reserved.