NVIDIAのGPUは「Blackwell Ultra」から「Rubin」へ、シリコンフォトニクスも採用:人工知能ニュース

NVIDIAは、米国サンノゼで開催中のユーザーイベント「GTC 2025」の基調講演において同社のGPUアーキテクチャのロードマップを発表した。

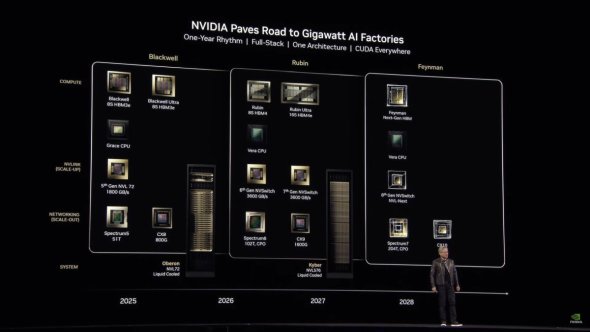

NVIDIAは2025年3月18日(現地時間)、米国サンノゼで開催中のユーザーイベント「GTC(GPU Technology Conference) 2025」(開催期間:同年3月17〜21日)の基調講演において同社のGPUアーキテクチャのロードマップを発表した。同年後半に現行の「Blackwell」の強化版である「Blackwell Ultra」を投入した後、2026年後半に新世代となる「Rubin」、2027年後半にその強化版「Rubin Ultra」と1年ごとに最新技術を展開し、加速度的に進むAI(人工知能)技術の進化をけん引していく方針である。

NVIDIA 創業者兼CEOのジェンスン・フアン(Jensen Huang)氏は「かつてのLLM(大規模言語モデル)と比べて、より進化したエージェントAIで用いられるリーズニングモデル(Reasoning Model)は正しい答えを導き出すためにより多くのトークンと計算処理性能を要求する」と語る。

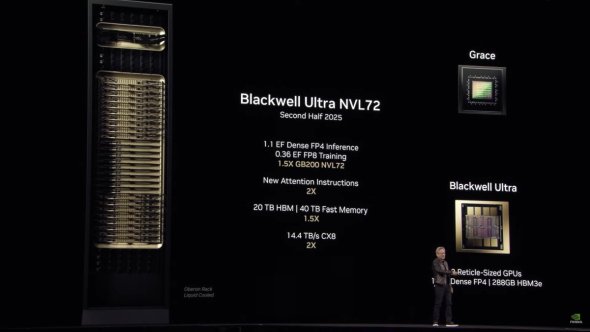

Blackwell Ultraは、このようなさらなるAI処理性能への要求を満たすべく開発された。Blackwellと同様に2チップ構成であり、搭載メモリもHBM3eで変わらないものの、メモリ容量はBlackwellの192GBから1.5倍の288GBに増えた。FP4(4ビット浮動小数点演算)/Denseの推論実行におけるAI処理性能は15PFLOPSとなっている。

AIサーバ向けに展開されるBlackwellは、GPU×72個とCPUの「Grace」×36個をインターコネクトであるNVLinkで接続した「GB200 NVL72」を1台のサーバラックを構成する基本単位としている。Blackwell Ultraでは同様の構成で名称は「GB300 NVL72」となる。GB300 NVL72のAI処理性能は、FP4/Denseの推論実行で1.1EFLOPS、FP8(8ビット浮動小数点演算)の学習で0.36EFLOPSと、GB200 NVL72の1.5倍になっている。

2026年後半に登場するRubinでは、GPUに加えて組み合わせて使用するCPUも「Vera」に刷新される。GPUは2チップ構成を継承する一方で、搭載メモリもHBM4に進化する。メモリ容量はBlackwell Ultraと同様に288GBとなる。AI処理性能(FP4)は、Blackwell Ultraの15PFLOPSから約2.6倍の50PFLOPSと大幅に向上する見込み。CPUのVeraは、Armベースのカスタムコアを88個集積し、176スレッド動作となる。1台のサーバラックを構成する基本単位は「Vera Rubin NVL144」となり、AI処理性能はFP4の推論実行で3.6EFLOPS、FP8の学習で1.2EFLOPSとなり、GB300 NVL72の3.3倍を想定している。

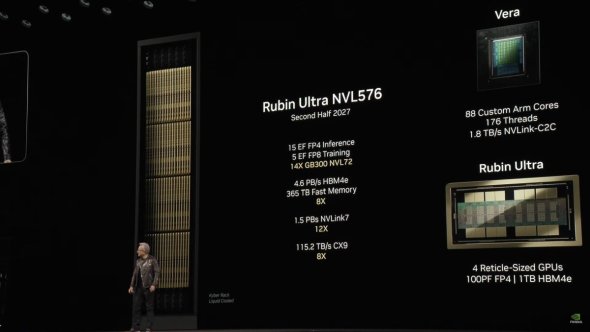

2027年後半にはRubinの強化版の「Rubin Ultra」を投入する。Rubin UltraはGPUが4チップ構成とさらに巨大になる。メモリはHBM4eで、容量も1TBに到達する。AI処理性能(FP4)は、Rubinの2倍の100PFLOPSだ。1台のサーバラックを構成する基本単位は「Rubin Ultra NVL576」で、AI処理性能はFP4の推論実行で15EFLOPS、FP8の学習で5EFLOPS。Vera Rubin NVL144の4倍以上になる見込みだ。

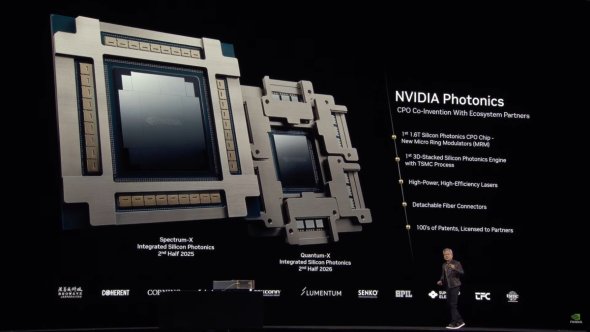

また、AIサーバを複数接続してAI処理性能を高めていくためには、GPUアーキテクチャだけでなくインターコネクトの進化も必要になる。高速インターコネクトを使うことによる消費電力の増大という課題に対応するため、シリコンフォトニクスICを採用したインターコネクトを発表した。イーサネットスイッチの「NVIDIA Spectrum-X」とInfinibandスイッチの「NVIDIA Quantum-X」で、帯域幅が1.6TPSで、電力効率が3.5倍、シグナルインテグリティーが63倍、耐久性が10倍など大幅な性能向上を果たしているという。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

エッジにも浸透する生成AI、組み込み機器に新たな価値をもたらすか

エッジにも浸透する生成AI、組み込み機器に新たな価値をもたらすか

生成AIが登場して2年以上が経過しエッジへの浸透が始まっている。既にプロセッサやマイコンにおいて「エッジAI」はあって当たり前の機能になっているが、「エッジ生成AI」が視野に入りつつあるのだ。 NVIDIAの新アーキテクチャ「Blackwell」は生成AI特化、汎用人型ロボットにも適用

NVIDIAの新アーキテクチャ「Blackwell」は生成AI特化、汎用人型ロボットにも適用

NVIDIAは「GTC 2024」において、新たなGPUアーキテクチャ「Blackwell」を発表。AI処理性能で前世代アーキテクチャ「Hopper」の5倍となる20PFLOPSを達成。生成AIの処理性能向上にも注力しており、Hopperと比べて学習で4倍、推論実行で30倍、消費電力当たりの処理性能で25倍となっている。 NVIDIAは車載プラットフォームも「Blackwell」世代へ、MediaTekとの協業も進展

NVIDIAは車載プラットフォームも「Blackwell」世代へ、MediaTekとの協業も進展

NVIDIAは「GTC 2024」の基調講演において、新世代の車載コンピューティングプラットフォーム「NVIDIA DRIVE Thor」を発表した。同社の新たなGPUアーキテクチャである「Blackwell」の採用によりAI処理性能は1000TFLOPSを達成している。 NVIDIAが毎年新製品を投入できる理由、半導体設計のコーディングにLLMを活用

NVIDIAが毎年新製品を投入できる理由、半導体設計のコーディングにLLMを活用

NVIDIAは、高性能チップの国際学会である「Hot Chips 2024」での講演内容について発表した。 NVIDIAのファンCEOが断言「ロボットAI革命をリードするのは日本がふさわしい」

NVIDIAのファンCEOが断言「ロボットAI革命をリードするのは日本がふさわしい」

NVIDIAが東京都内で開催したユーザー向けイベント「NVIDIA AI Summit Japan」の基調講演にCEOのジェンスン・フアン氏が登壇。生成AIの登場によって「AIエージェント」と「フィジカルAI」という2つのAIアプリケーションが普遍的に利用されるようになり、特にフィジカルAIによるロボットの進化は日本がリードすべきと訴えた。 「Jetson Orin Nano」のAI処理性能が70%向上、開発者キットの価格も半額に

「Jetson Orin Nano」のAI処理性能が70%向上、開発者キットの価格も半額に

NVIDIAは、組み込み機器向けAIモジュール「Jetson Orin Nano」の開発者キットについて、AI処理性能が従来比で70%増となる67TOPSに向上した「Jetson Orin Nano Super開発者キット」を発表した。価格も従来の499米ドルから半額となる249米ドルに値下げする。