NVIDIAの新アーキテクチャ「Blackwell」は生成AI特化、汎用人型ロボットにも適用:人工知能ニュース(1/2 ページ)

NVIDIAは「GTC 2024」において、新たなGPUアーキテクチャ「Blackwell」を発表。AI処理性能で前世代アーキテクチャ「Hopper」の5倍となる20PFLOPSを達成。生成AIの処理性能向上にも注力しており、Hopperと比べて学習で4倍、推論実行で30倍、消費電力当たりの処理性能で25倍となっている。

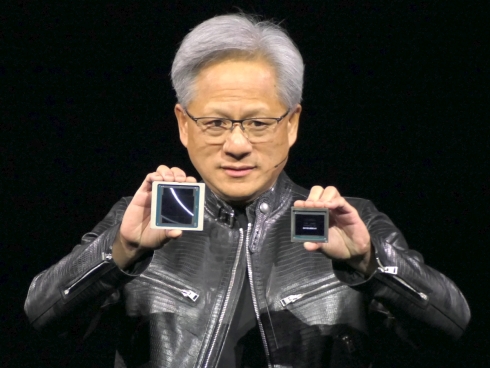

NVIDIAは2024年3月18日(現地時間)、米国サンノゼで開催中のユーザーイベント「GTC(GPU Technology Conference) 2024」(開催期間:同年3月17〜21日)の基調講演において、新たなGPUアーキテクチャ「Blackwell」を発表した。浮動小数点演算ベースのAI(人工知能)処理性能で、2022年3月発表の前世代アーキテクチャ「Hopper」の5倍となる20PFLOPSを達成。LLM(大規模言語モデル)など生成AIの処理性能向上にも注力しており、Hopperと比べて学習で4倍、推論実行で30倍、消費電力当たりの処理性能で25倍となっている。Blackwellを採用した製品は2025年後半からの市場投入を予定している。

NVIDIA 創業者兼CEOのジェンスン・フアン(Jensen Huang)氏は「Blackwellは、これからの時代を定義して行くであろう生成AIという新たな産業革命を推進するエンジンになるだろう。さまざまなパートナー企業と連携することで、あらゆる産業がその恩恵を受けられるようにしたい」と語る。

なお、Blackwellの名称は、ゲーム理論を提唱した数学者/統計学者で、黒人として初の米国科学アカデミー会員に選ばれたデビッド・ハロルド・ブラックウェル(David Harold Blackwell)氏に由来している。

BlackwellのGPUは2ダイ構成、総トランジスタ数は2080億

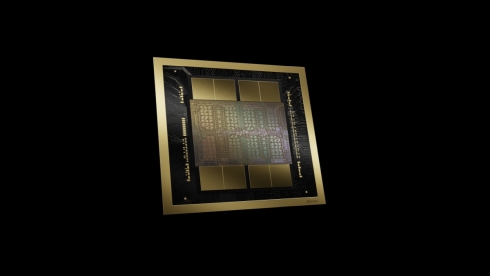

Blackwellを実現するために複数の新たな技術を導入した。1つ目は、複数チップの組み合わせによって処理性能を向上するチップレット技術の導入によって、1パッケージに集積する回路規模をより大きくしたことだ。TSMCの「4NPプロセス」で利用できる最大のフォトマスクサイズで製造した2個の半導体ダイをNV-HBIと呼ぶ帯域幅10TB/sのバスで接続するとともに、最新のメモリインタフェースであるHBM3eに対応する容量192GBのRAMを搭載している。1パッケージの中に集積されているトランジスタ数は2080億個で、HOPPERの800億個の2.6倍に達する。

2つ目は、第2世代のトランスフォーマーエンジンの採用である。LLMの開発環境である「TensorRT-LLM」と「NeMo Megatron」に、新たなマイクロ行列スケーリングをサポートするとともに動的範囲管理アルゴリズムを統合したとしている。HopperではAIモデルの演算精度としてFP8(8ビット浮動小数点演算)が加わったが、BlackwellではFP4(4ビット浮動小数点演算)が新たに加わっている。Blackwellの浮動小数点演算ベースのAI処理性能として冒頭に挙げた20PFLOPSは、FP4で実現したものだ。

3つ目は、外部システムとの接続に用いる新たなインターコネクトとして開発した第5世代「NVLink」の採用である。帯域幅は第4世代比2倍の1.8TB/sで、576個のGPUをつなげて1個のGPUとして運用可能なシステムを構築できる。特に、パラメータ数が1兆個を超えるようなLLMモデルを効率的に処理するには、クラウドやサーバ内でAI処理のシステムを構成している複数個のGPU間で高速にデータをやりとりする必要があるが、既存のInfiniBand EDRの帯域幅100GB/sがボトルネックになっていた。

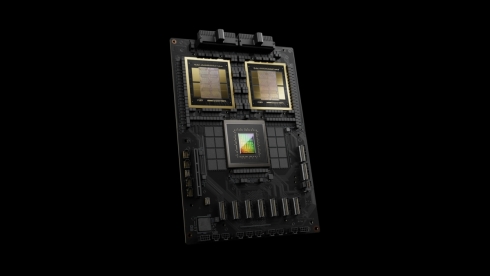

この第5世代NVLinkを活用した新たなAIシステムの単位となる「GB200 NVL72」も発表している。Armのサーバ向けプロセッサ「Neoverse」を採用したCPU「Grace」1個と2個のBlackwellから構成される「GB200 Superchip」を2セット分搭載するラックマウント型サーバ「GB200 Superchip Compute Tray」と、複数のGB200 Superchip Compute Trayを第5世代NVLinkをベースに開発したスイッチIC「NVLink Switch」によってつなぐ「NVLink Switch Tray」を組み合わせたものだ。GB200 Superchip Compute Trayの搭載数は18台で、AI処理性能は学習で720PFLOPS(FP8)、推論実行で1440PFLOPS(FP4)に達する。

なお、GB200 NVL72のAI処理性能は、HopperベースのGPU「H100」を同じコア数を用いて構成したAIシステムと比較した場合に、パラメータ数1750億個のGPT-3で6倍だが、特定のタスクを得意とするAIモデルを複数組み合わせるためパラメータ数1兆8000億個と大きくなる混合エキスパート(Mixture of Experts)モデルでは30倍に伸びるという。

Blackwellではこれらの他にも、より大規模なAIモデルを扱う生成AIで重要な信頼性、可用性、サービス性の向上が可能な「RASエンジン」、個人情報を慎重に取り扱わなければならないヘルスケアや金融などの産業分野向けにデータ保護を処理性能を落とさずに行える「Secure AI」、データ分析やデータサイエンスの処理性能向上に求められる最新のデータベース形式に対応可能な「デコンプレッションエンジン」を採用している。

なお、これらの特徴を持つBlackwellを搭載したクラウドは、AWS(Amazon Web Services)、Microsoft、Google、Oracleが2024年後半に提供を始める予定だ。NVIDIA自身もクラウドサービスの「NVIDIA DGX Cloud」で提供する方針。また、Ansys、Cadenece Design Systems、Synopsysなどの主要CAEベンダーも、Blackwellの処理性能を最大限引き出せるようにCAEソルバーを最適化して行く方針を示している。

Copyright © ITmedia, Inc. All Rights Reserved.