勝利を約束されたArmのAI戦略、MCUの微細化も加速させるか:Arm最新動向報告(9)(3/3 ページ)

Armが開催した年次イベント「Arm TechCon 2019」の発表内容をピックアップする形で同社の最新動向について報告する本連載。今回は、「Ethosシリーズ」や「ArmNN」などを中核に進めるArmのAI戦略について紹介する。

MCUにもAIを適用して「エンドポイントAI」を提唱

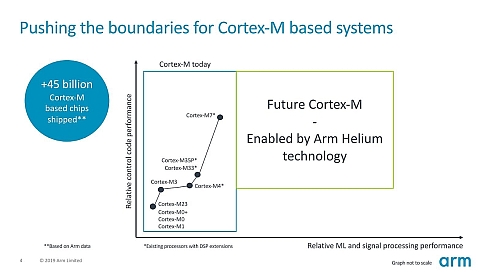

さて、ここまでの話はCortex-AのCPUを対象にした話だったが、Arm TechCon 2019ではMCUに用いられる「Cortex-M」向けで強烈な「Helium」推しがあった(図5)。

図5 具体的な数字としては、信号処理(Signal Processing)で最大5倍、MLのパフォーマンスで最大15倍という数字や、キーワード抽出で90%、CIFAR-10のイメージ特定で83%の処理時間削減が可能になる(ので、その分消費電力を減らせる)といったものが示された(クリックで拡大)

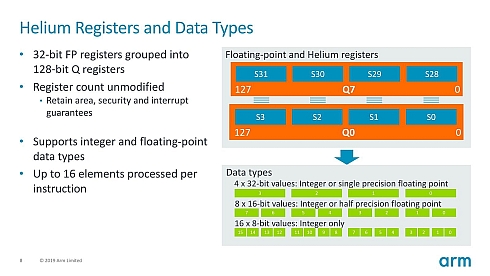

Heliumは、2019年2月に発表された「Arm v8.1-M」で新たに追加されたMVE(M-Profile Vector Extention)で、要するにCortex-Mで利用できる128bitのSIMDエンジンである(図6)。従来、Cortex-Mには「CMSIS-NN」と呼ばれるフレームワークが提供されており、これはCortex-M4のDSP命令などを利用することでNNを効率的に動かそうというものであったが、Heliumでは(この時は発表されなかったが)ArmNNでの利用が可能となっている。

これを念頭に置いた上で、2020年2月に発表があった「Cortex-M55」と「Ethos-U55」を眺めると、Cortex-Aと同じ戦略をCortex-Mでも推し進めようとしていることが見えてくる。つまり、今後はHeliumを実装するCortex-Mが増えてくるので、まずはこれである程度の性能を持ったソリューションが構築可能であり、より性能が欲しい場合にはEthos-U55を組み合わせることで、アプリケーションの書き換えなしにより高い性能が得られる、というシナリオである。

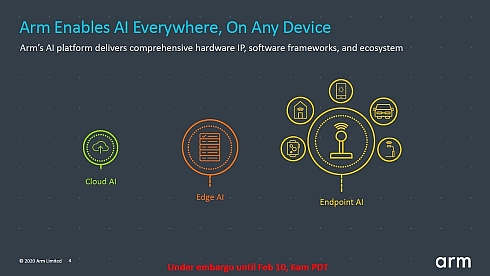

この発表に合わせてArmはエンドポイントAI(Endpoint AI)という概念を発表した(図7)。これまでIoT(モノのインターネット)におけるAI処理は、クラウドあるいはせいぜいがエッジ止まりだったのを、今後はエンドポイントにも広げたいという戦略である。

この領域は今のところまだ手付かずの、いわばブルーオーシャンであり、スマートフォン向けのレッドオーシャンとはちょっと様相が異なる。もちろんCEVAやVeriSiliconのように、MCUに向けたNPU IPを提供しているベンダーはあるし、ETA Computeのように「Cortex-M3」に独自のDSPベースNPUを搭載した製品の出荷を開始したベンダーもある。さらに言えば、このマーケットは小規模FPGAとも思いっきり競合するわけで、Lattice SemiconductorとかQuickLogicなどのソリューションともかなりぶつかる部分はあるが、スマートフォンと異なりこれから大きな伸びる可能性が高いだけに、今から手を打っておけば将来のマーケットが期待できるという側面はある。

早くもNXPは、将来のMCU/Crossover MCU向けにEthos-U55に関してArmとパートナーシップを結ぶなど、MCUのマーケットでも一波乱ありそうな勢いである。

気になるのは製品の投入時期である。Cortex-M55とEthos-U55の発表会で明らかにされたのは、Cortex-M55コアそのものはCortex-M33コアとほぼ同一のエリアサイズであるが、Heliumを実装するとこれが倍になるという事実だった。そして、Ethos-U55のエリアサイズは最小の32MAC構成でもCortex-M33と同じ程度というのだ。

Ethos-U55の利用にはDSP拡張が必要なので、事実上Heliumの実装が必要になる。つまり、Cortex-M55+Ethos-U55という構成は、現行のCortex-M33の3倍ほどのエリアサイズになるわけだ。Ethos-U55を最大構成(256MAC)にすれば10倍になるだろう。こうなると、今のCortex-M33(55〜40nmプロセスで製造)と同じ製造プロセスではペイしないのは明白で、最小の32MAC構成なら28nmプロセスでなんとかなりそうだが、最大構成だと16/14/12nmあたりのFinFETプロセスを考慮しないといけないサイズになる。28nmは既に先端(主に自動車向け)MCUでは実用になっているが、まだメインストリーム向けは相対的に安い40nmプロセスあたりを使うことが多い。

Armの言うエンドポイントAIを実現するためには、さらなる微細化が必要なわけで、このコストを正当化できるだけのアプリケーションが必要になる。いずれはMCUも28nmに移行するだろうとは広く考えられていたが、エンドポイントAIに向けたArmの戦略が、この28nmプロセスへの移行を早めることになるのかもしれない。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

- ≫連載「Arm最新動向報告」バックナンバー

Armが提唱する「エンドポイントAI」の処理性能は従来比で最大480倍に

Armが提唱する「エンドポイントAI」の処理性能は従来比で最大480倍に

Armがマイコン向けプロセッサコアIP「Cortex-Mシリーズ」の最新プロダクト「Cortex-M55」と、Cortex-Mシリーズとの組み合わせにより機械学習ベースの推論アルゴリズムを効率的に実行できるNPU「Ethos-U55」を発表。Cortex-M55とEthos-U55を組み合わせた場合、現行の「Cortex-M33」と比べて推論アルゴリズムの処理性能は最大480になる。 普及価格のデバイスにもAIを、Armの新たなプロセッサIP

普及価格のデバイスにもAIを、Armの新たなプロセッサIP

アームは2019年12月6日、東京都内で記者説明会を開き、メインストリーム向けプロセッサIP(Intellectual Property)の最新動向を解説した。機械学習や美麗なグラフィックスによる高品位なユーザー体験の提供を、普及価格帯のモバイルデバイスや民生機器にも拡大するという。 AIやAR、VRを民生機器用デバイスへ搭載できる最新プロセッサIPを発表

AIやAR、VRを民生機器用デバイスへ搭載できる最新プロセッサIPを発表

Armは、AIやAR、VR搭載のモバイルデバイスやコンシューマー機器向けに、ML向けプロセッサ「Arm Ethos-N57」「Arm Ethos-N37」、Maliグラフィックスプロセッサ「Arm Mali-G57」、Maliディスプレイプロセッサ「Arm Mali-D37」を発表した。 「機械学習を全てのデバイスに」、Armが進めるプロセッサの性能向上

「機械学習を全てのデバイスに」、Armが進めるプロセッサの性能向上

Armは2019年4月4日、東京都内で記者説明会を開き、クライアントコンピューティング向けに展開する推論エンジンのプラットフォーム「Arm NN」や、CPU、GPUや機械学習用プロセッサ「NPU」の動向について紹介した。 Arm「Cortex-M」に拡張機能、機械学習性能が最大15倍へ

Arm「Cortex-M」に拡張機能、機械学習性能が最大15倍へ

Armは、「Arm Cortex-M」シリーズ向けのMプロファイルベクトル拡張機能(MVE)「Arm Helium」テクノロジーを発表した。最新の「Armv8.1-M」アーキテクチャの演算能力を強化し、次世代のArm Cortex-Mプロセッサの機械学習性能を最大15倍向上させる。