AIに“全方位”で挑むインテル、GPUや専用プロセッサとどう戦うか:組み込み開発ニュース(2/2 ページ)

インテルは2018年12月17日、東京都内で記者説明会を開催し、2018年における同社の活動の振り返りと2019年以降の展望について説明した。本稿では、説明会で示された内容の中でAI(人工知能)やB2Bコンピューティングに関するトピックを中心に紹介する。

AI分野でも「全方位で顧客ニーズに対応する」インテル

また、2018年にインテルが注力した技術動向については、同社で執行役員常務 技術本部 本部長を務める土岐英秋氏が紹介を行った。

データセンター向けのテクノロジーについて、土岐氏は「データの移動、保存、処理といった3つの切り口で説明することが多い」とし、これらを実現する同社のネットワーク、ストレージ、プロセッサ技術について順に解説した。

1点目のネットワーク技術に関して、土岐氏は「現在のデータセンターでは、内部ネットワークのトラフィックが急増している」と指摘し、「インテルでは内部コネクティビティについても3つの技術を保有する」と説明。同社ではネットワーク技術について、HPC(ハイパフォーマンスコンピューティング)クラスのファブリックである「Omni-Path」を筆頭に、イーサネット、そしてシリコンフォトニクスでポートフォリオを構成している。

土岐氏は、特に2019年に提供予定の次世代イーサネットインタフェース「Cascade Glacier」について、「FPGAが乗っており非常にスマートなNIC(ネットワークインターフェースカード)となっている」と語る。

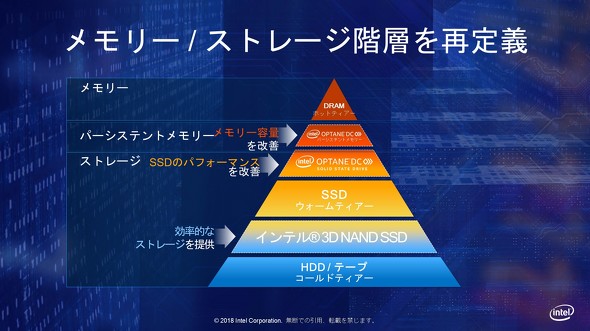

2点目のメモリ/ストレージ技術について土岐氏は、DRAMを頂点としてHDD(ハードディスクドライブ)を土台とした、メモリ・ストレージ階層の速度差と容量差を埋める製品を同社が用意していると強調する。

特に、従来のSSD(ソリッドステートドライブ)とDRAMのすき間を埋める製品として、同社の3D XPoint技術を用いた「Optane DC SSD」や「Optane DC Persistent Memory」を紹介し、どちらの製品も非常に高速なストレージとして活用できるが、Optane DC Persistent Memoryは「メインメモリのアドレス空間上で使うことができる不揮発性メモリ」(土岐氏)であるため、「プロセッサに多くのデータを高速に渡すというコンピューティングの考え方ができる」製品だとする。

最後のプロセッサ技術に関しては、Xeonで最新世代となる開発コードネーム「Cascade Lake」を紹介した。14nmプロセスで製造される同プロセッサでは、前世代と比較して新たにOptane DC Persistent Memoryをサポートしつつも、動作周波数の向上とキャッシュ階層の最適化、セキュリティ脆弱性の軽減などを果たしたとする。

また、2018年11月に発表された「Cascade Lake Aadvanced Performance」ではマルチチップパッケージにより1パッケージに複数のチップを搭載することで最大48コア、1ソケット当たり12チャンネルのDDR4メモリをサポートする。同製品のディープラーニング推論性能は、従来製品の「Xeon Platinum Prosessor」と比較して最大17倍の改善があるという。

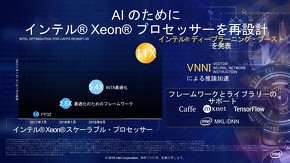

Cascade Lakeは「AIのためにプロセッサを再設計した」(土岐氏)とし、この世代のXeonから新たに「Intel Deep Learning Boost」をサポートする。同技術はVNNI(Vector Neural Network Instruction)による推論の高速化を実現。2017年7月に登場したXeonプロセッサでFP32(単精度浮動小数点)を用いた場合と比較して、最大で11倍の推論スループット高速化が望めるという。同技術はCaffeやMXNet、TensorFlowなどのディープラーニングフレームワークに対応する予定だ。

ディープラーニングの学習や推論の演算処理についてGPUが大きな存在感を示す中、さらには専用プロセッサ、ASICの活用を進める動きも目立ってきた。AIがデータセンターのワークロードで大きな割合を占める状況で、ディープラーニング処理用途におけるCPUの役割や、インテルの勝ち筋はどこにあるのだろうか。

この問いに対して、土岐氏は「GPUや専用プロセッサが一定のワークロードで高速な演算性能を発揮するのは確かだ」と前置きしつつ、「しかし、ディープラーニングにおいても汎用的な処理を行うワークロードがなくなることはない。データセンターで取り扱うデータ量は飛躍的に増加しており、汎用的なワークロード量も増加すると見ている。これらによりCPUのニーズも伸びると考えている」と回答する。

また、加えて土岐氏は「ディープラーニングに関する全てのワークロードがクラウド上で実行されるわけではなく、エッジ上で推論を行うニーズもある。われわれはこのニーズに対し、Atomや専用アクセラレーターであるMovidiusなどでカバーできる。また、われわれのCPUやFPGA、専用アクセラレーターを共通コードで扱うことができるコンピュータビジョン開発用のツールキット『OpenVINO』も提供する」と語る。

「顧客のニーズに沿った製品を全方位で提案でき、容易な開発もサポートする。これは他のプロセッサにはない強みだ」(土岐氏)。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

インテルのUSBスティック型組み込みAIデバイス、最新版の動作デモが公開中

インテルのUSBスティック型組み込みAIデバイス、最新版の動作デモが公開中

岡谷エレクトロニクスは、「Embedded Technology 2018/IoT Technology 2018(ET2018)」のインテルブース内で、発表されたばかりのUSBスティック型組み込みAIデバイスの最新モデル「Intel Neural Compute Stick 2(NCS 2)」の動作デモを披露した。 インテルが画像認識ソフト開発ツールを無償提供「IoTの“I”は“Eye”」

インテルが画像認識ソフト開発ツールを無償提供「IoTの“I”は“Eye”」

インテルは2018年6月28日、東京都内で「インテル インダストリアル IoT ソリューション DAY」を開催。「IoTの“I”は“Eye(目)”ではないかと思うほどに、画像認識技術がより重要になっている」(同社)とし、画像認識ソフトウェアの開発ツール「OpenVINOツールキット」を無償で提供するなどしている。 インテルのFPGAはソフト開発者でも簡単に扱える、デルと富士通がサーバに採用

インテルのFPGAはソフト開発者でも簡単に扱える、デルと富士通がサーバに採用

日本アルテラがデータセンター向けに展開を強化しているFPGA事業の戦略について説明。デルEMCと富士通のサーバ製品群に、ソフトウェア開発者でもFPGAを容易に扱える環境を用意した「インテルPACカード」が採用されたことを明らかにするとともに、国内のオンプレミスサーバ市場に向けて積極的に提案していく方針を示した。 HDLを知らなくてもFPGAの力を引き出せる、インテルが無償のOpenCL開発環境

HDLを知らなくてもFPGAの力を引き出せる、インテルが無償のOpenCL開発環境

日本アルテラは、FPGAでOpenCLを扱うためのソフトウェア開発環境「Intel FPGA SDK for OpenCL」の最新バージョン「17.1」について説明。従来のコマンドラインベースのツールから、GUIを用いた統合開発環境となるとともに、新たに高速のエミュレータとコンパイラが加わった。 PFNが深層学習プロセッサを開発した理由は「世界の先を行くため」

PFNが深層学習プロセッサを開発した理由は「世界の先を行くため」

Preferred Networks(PFN)は2018年12月12日、ディープラーニングに特化したプロセッサ「MN-Core(エムエヌ・コア)」を発表した。同プロセッサは学習の高速化を目的とし、行列の積和演算に最適化されたものとなる。FP16演算実行時の電力性能は世界最高クラス(同社調べ)の1TFLOPS/Wを達成した。 “プロセッサ”を開発する東芝メモリ、その技術と狙い

“プロセッサ”を開発する東芝メモリ、その技術と狙い

東芝メモリがプロセッサの開発を発表した。現業から離れているように見えるプロセッサの開発を通じて東芝メモリは何を目指すのか。今回発表された技術の概要と開発の狙いを聞いた。