Jetson Orinの生成AI処理性能はXeonの1.7倍、NVIDIAが“史上最大”の機能拡張へ:人工知能ニュース(1/2 ページ)

NVIDIAは、組み込み機器向けのエッジAI開発プラットフォームである「Jetson」について、生成AIへの対応を含めた大幅な機能拡張を行うと発表した。

NVIDIAは2023年10月18日(現地時間)、組み込み機器向けのエッジAI(人工知能)開発プラットフォームである「Jetson」について、生成AIへの対応を含めた大幅な機能拡張を行うと発表した。最新の組み込み機器向けAIモジュールである「Jetson Orin」を中核に、最新のオープンソースの生成AIモデルをJetsonにデプロイ可能な形で提供する「NVIDIA Jetson Gen AI Lab」のサービスを開始する他、ビジョンAIプラットフォーム「NVIDIA Metropolis」やロボット開発プラットフォーム「NVIDIA Isaac」との連携を深めるとともに、開発環境の「JetPack」についても最新版となる「JetPack 6」で対応可能なサードパーティー製Linuxの拡充などを図るという。

ChatGPTの登場で一気に注目が集まった生成AIだが、産業分野を中心に120万人以上の開発者がいるJetsonでの活用にも期待が集まっている。最新のAIモジュールであるJetson OrinのAI処理性能は、ハイエンドの「Jetson AGX Orin」で275TOPS(1TOPSは毎秒1兆回の演算性能)、開発者キットの価格が499米ドルとより安価なエントリークラス製品の「Jetson Orin Nano」でも40TOPSとなっており、生成AIのAIモデルの処理にも対応可能とみられていた。

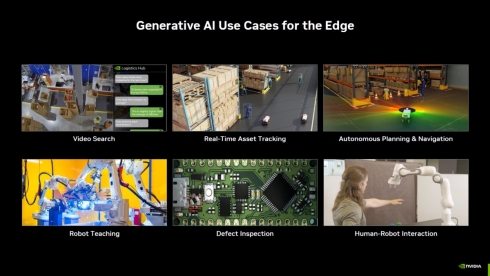

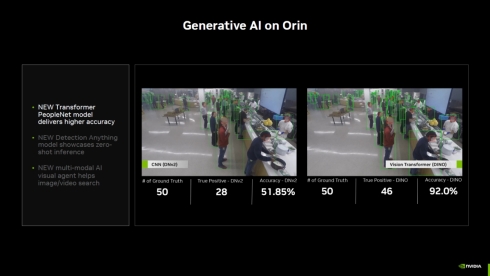

Jetson Orinにおける生成AIのユースケースとしては、自然言語認識と連携した映像検索や、リアルタイムのアセットトラッキング、AGV(無人搬送車)やAMR(自律搬送ロボット)の自律移動、産業用ロボットのティーチング、欠陥検査、人とロボットの協働などさまざまなものが想定されている。例えば、画像内から人を検出するAIモデルのPeopleNetは、従来の深層学習を用いたモデルの精度が約52%だったのに対し、生成AIモデルであるビジョントランスフォーマー(ViT)に置き換えることで精度が約92%に向上する。Jetson Orinであれば、クラウドではなくエッジデバイスでこの性能向上を享受することができる。

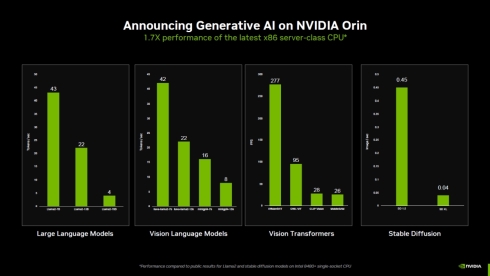

NVIDIAは、Jetson AGX Orinによる各種生成AIモデルのベンチマークスコアを発表している。例えば、大規模言語モデル(LLM)のLlama2-7Bは43Tokens/sec、大規模視覚モデル(VLM)のllava-llama2-7bは42Tokens/sec、ViTのEfficientViTで277FPS、Stable DiffuisonのSD 1.5で0.45Image/secとなっており、これらの性能はインテルの最新サーバ向けプロセッサ「Xeon Platinum 8480+」の1.7倍になるという。

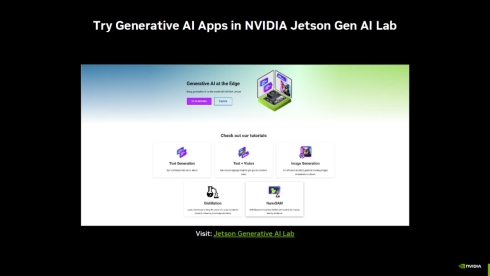

このようにJetson Orinの投入によってエッジでも生成AIの活用を検討できるようになったことに併せて今回発表したのが、オープンソースの生成AIモデルをJetsonにデプロイして試すためのサービスであるNVIDIA Jetson Gen AI Labだ。なお、NVIDIA Jetson Gen AI Labで提供する生成AIモデルの調整やカスタマイズは「NVIDIA TAO Toolkit」で行えるため、ただ単に生成AIの動作を試すだけでなく、より実用に近い形での開発も可能になっている。

Copyright © ITmedia, Inc. All Rights Reserved.