エッジデバイス上でも動作するキーワード検出機能付き話者認識AIを開発:人工知能ニュース

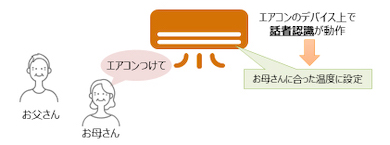

東芝は、エッジデバイス上で高速に動作する、音声キーワード検出機能付きの話者認識AIを開発した。ネットワーク接続なしでも3回の発話で話者登録が完了し、音声で操作したり、話者に合わせて機器の動きを変更したりできるようになる。

東芝は2020年2月20日、エッジデバイス上で高速に動作する、音声キーワード検出機能付きの話者認識AI(人工知能)を発表した。同技術を家電に搭載することで、ネットワーク接続なしでも3回の発話で話者登録が完了し、音声で操作したり、話者に合わせて機器の動きを変更できるようになる。

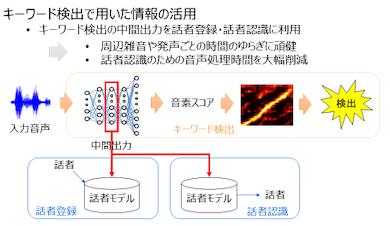

今回開発されたAIは、音声が入力されるとキーワード検出のニューラルネットワークで周辺雑音などの影響を抑制しながら音声を処理し、ニューラルネットワークの中間出力を用いて話者を登録、認識する。中間出力を用いることで、話者認識の際にも周辺雑音の影響を抑えられ、話者認識にかかる処理時間を大幅に削減できる。

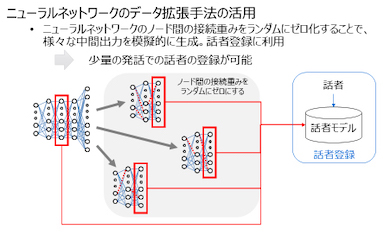

また、同技術では、ニューラルネットワークのデータ拡張手法を活用した。データ拡張手法は少ないデータで学習する手法であり、ニューラルネットワークのノード間の接続の重みを無作為にゼロにすることで、同一人物がさまざまな話し方で発話したかのような音声情報を模擬的に生成する。発話数が少なくても話者を学習できるため、話者登録時に必要となる発話数を削減できる。

各話者の3回の発話を話者登録に用いるという条件で同技術を評価したところ、話者100人で89%という識別結果が得られた。話者認識の一般的な手法「i-vector」は同じ条件で71%だった。また、計算量と処理速度をサーバで計測したところ、処理能力に制約がある組み込みシステムにおいても、問題なく動作することが分かった。

同社は、同技術を実際の組み込みシステムに搭載し、家電などで実用性の検証を進める。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

組み込みAIは必要不可欠な技術へ、推論に加えて学習も視野に

組み込みAIは必要不可欠な技術へ、推論に加えて学習も視野に

2017年初時点では芽吹きつつあった程度の組み込みAI。今や大きな幹にまで成長しつつあり、2019年からは、組み込み機器を開発する上で組み込みAIは当たり前の存在になっていきそうだ。 AIと機械学習とディープラーニングは何が違うのか

AIと機械学習とディープラーニングは何が違うのか

技術開発の進展により加速度的に進化しているAI(人工知能)。このAIという言葉とともに語られているのが、機械学習やディープラーニングだ。AIと機械学習、そしてディープラーニングの違いとは何なのか。 機械学習はどうやって使うのか――意外と地道な積み重ね

機械学習はどうやって使うのか――意外と地道な積み重ね

前編では、AI(人工知能)と機械学習、ディープラーニングといった用語の説明から、AIを実現する技術の1つである機械学習が製造業を中心とした産業界にも徐々に使われ始めている話をした。後編では、機械学習を使ったデータ分析と予測モデル作成について説明する。 人の曖昧な命令を自動補完するエッジAI、三菱電機が2022年にも製品搭載へ

人の曖昧な命令を自動補完するエッジAI、三菱電機が2022年にも製品搭載へ

三菱電機は人の曖昧な命令をエッジ機器単体で状況に応じて不足情報を自動補完して理解する「コンパクトな知識処理に基づくHMI制御技術」を開発した。同社のAI技術「Maisart」の1つで、テレビやカーナビゲーションシステムなどに用いられているプロセッサやメモリでも利用可能なエッジAI技術となる。 東芝が脊髄反射型アナログニューロンチップを開発、AI処理の応答速度は1μs以下

東芝が脊髄反射型アナログニューロンチップを開発、AI処理の応答速度は1μs以下

東芝情報システムは、「ET&IoT Technology 2019(ET2019)」において、ニューラルネットワーク向けのアナログ回路を搭載したICである「アナログニューロンチップ」を披露。1μs以下と高速な応答速度を実現していることから“脊髄反射型アナログニューロンチップ”と呼んでいる。 心臓病の発症リスク予想へ、AI技術開発をスタート

心臓病の発症リスク予想へ、AI技術開発をスタート

東芝は、ジョンズ・ホプキンス大学と共同で、心臓病の発症リスクを予測するAI技術の開発を開始した。3年以内の実用化を目指している。