脳細胞の活動を深層ニューラルネットワークに写し取る手法を開発:医療技術ニュース

東京大学は、目で見た画像に対して脳細胞がどのように活動するかを深層ニューラルネットワークに写し取る手法を開発した。脳内における感覚情報の処理機構の解明や、人間に近い振る舞いをする人工知能の作成につながることが期待される。

東京大学は2019年3月7日、目で見た画像に対して脳細胞がどのように活動するかを深層ニューラルネットワークに写し取る手法を開発したと発表した。これは、同大学大学院医学系研究科教授 大木研一氏らの研究グループによる研究成果だ。

動物が視覚から物体の位置や動きなどの情報を得る際、それらの情報は大脳皮質の多くの領域で段階的に処理されている。最初の段階(1次視覚野)から何段階も先の側頭葉には、顔の画像に対して特異的に反応する神経細胞があり、こういった特定の画像に神経細胞が良く反応する性質は「反応選択性」と呼ばれている。

従来の研究では、実験に用いる画像の数が限られることや、実験者の仮説を検証する形となるため、重要な反応選択性を見逃している可能性があった。今回の研究では、仮説を問わず実験者の想定外の反応まで含めて、反応選択性を網羅的に解明する手法の開発を目指した。

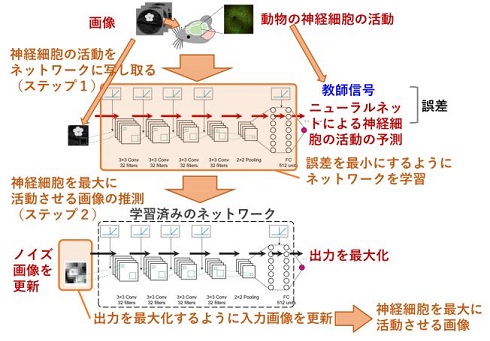

まず、動物に画像を見せ、同じ画像を深層ニューラルネットワークに入力し、画像に対する神経細胞の活動を教師信号として深層ニューラルネットワークに学習させた。次に、用意したノイズ画像の輝度値を繰り返し更新することにより、ニューラルネットワークの出力を最大にする画像をコンピュータ上で生成した。

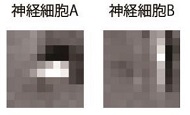

この手法を、マウスに数千枚の画像を見せた際の、1次視覚野における神経細胞の活動データに適用したところ、高い精度で新規画像に対する神経細胞の活動を予測できた。さらに、学習済みネットワークの出力を最大化する画像を生成した結果、用意したノイズ画像の細かな違いにより、異なる2種の画像が生成された。研究グループは、この性質を利用することで、複数の異なる画像から細胞が反応しやすい画像を網羅的に作成できると考えた。

さらに、先の1次視覚野データから生成された画像により、2種の細胞の存在が確認できた。2種類の細胞は、それぞれ1次視覚野に存在する、特定の位置に特定の傾きの直線がある時に良く反応する「単純型細胞」と、傾いた直線の位置が多少ずれていても良く反応する「複雑型細胞」に対応していた。同手法を1次よりもさらに高次の視覚野に応用することで、まだ知られていない反応選択性が同定される可能性がある。

同手法は、視覚野以外に聴覚などの他の感覚野にも応用できるため、脳内における感覚情報の処理機構を解明するのに役立つ。また、今回得られた知見を取り入れることで、人間に近い振る舞いをする人工知能を作り出す可能性へとつながることが期待される。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

AIに最適な脳型LSI、東北大が脳機能のモジュール化で2019年度に実現へ

AIに最適な脳型LSI、東北大が脳機能のモジュール化で2019年度に実現へ

東北大学の電気通信研究所は、2014〜2019年度のプロジェクトで、AI(人工知能)に最適な脳型LSIの開発を進めている。脳機能をモジュール化して計算効率を高め、人間の脳と同等レベルの処理能力と消費電力を持つ脳型LSIの実現につなげたい考えだ。 インテルはAIで勝ち残れるのか、脳科学研究から生まれた「Crest」に賭ける

インテルはAIで勝ち残れるのか、脳科学研究から生まれた「Crest」に賭ける

世界最大の半導体企業であるインテルだが、AIやディープラーニングに限ればその存在感は大きいとはいえない。同社は2017年3月にAI製品を開発するAIPGを発足させるなど、AI関連の取り組みを強化している。2017年3月に発足したAI製品事業部の副社長兼CTOを務めるアミール・コスロシャヒ氏に話を聞いた。 脳を模倣したAIチップをNECと東大が実用化、総合的提携の一環で

脳を模倣したAIチップをNECと東大が実用化、総合的提携の一環で

NECと東京大学が基礎研究から人材育成、社会実装まで及ぶ総合的な産学連携に合意した。第1弾として脳の構造を模したAIである「ブレインモルフィックAI」の実用化と社会実装を進める。 人がモノを見たり想像したりする時の脳活動を解読、人工知能への応用も

人がモノを見たり想像したりする時の脳活動を解読、人工知能への応用も

京都大学は、ヒトの脳活動パターンを人工知能モデルの信号に変換し、どんな物体を見たり想像したりしているかを脳から解読する技術を開発した。脳からビッグデータを利用する先進的技術となり、脳型人工知能の開発が期待できる。 ヒトの脳全体をシミュレーション、1秒間の神経回路の処理を5分で再現

ヒトの脳全体をシミュレーション、1秒間の神経回路の処理を5分で再現

理化学研究所は、次世代スーパーコンピュータで、ヒトの脳全体の神経回路のシミュレーションができるアルゴリズムの開発に成功した。メモリを省力化し、既存のスパコン上での脳シミュレーションを高速化できた。 映像を見て感じた内容を脳から言語化する脳情報デコーディング技術を開発

映像を見て感じた内容を脳から言語化する脳情報デコーディング技術を開発

NICT脳情報通信融合研究センターは、映像を見て感じた「物体・動作・印象」の内容を、脳活動を解読して1万語の「名詞・動詞・形容詞」の形で言語化する脳情報デコーディング技術の開発に成功した。