パナソニックHDがマルチモーダルAIの生成速度を倍増、拡散モデルの適用で:人工知能ニュース(2/2 ページ)

パナソニックHDは、拡散モデルを応用し、従来比約2倍の生成速度を実現したマルチモーダルAI「LaViDa」を開発。従来の自己回帰型LLMが抱える生成遅延や全体制御の弱さを、独自の高速化技術で克服した。

生成速度2倍と高精度を両立、現場の「非構造化データ」活用へ

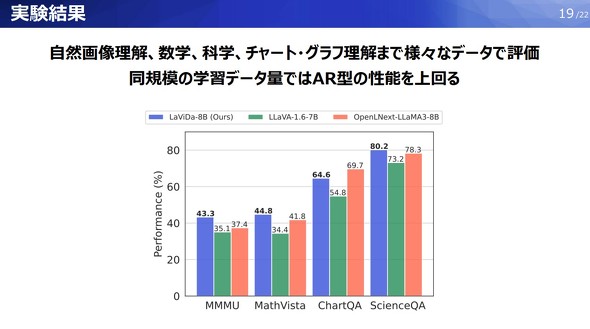

LaViDaの評価実験では、自然画像に関する質問応答に加え、数学やチャートなどが含まれるドキュメントの内容理解など、複数のデータセットを用いて検証を行った。その結果、同規模の学習データ量を用いた場合、LaViDaはいずれのタスクでも自己回帰モデルを用いたAIモデルを上回る性能を示した。

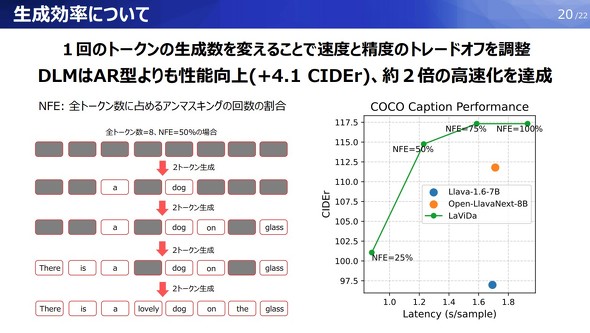

また、1回のトークン生成数を調整することで、速度と精度のトレードオフを実現。LaViDaは自己回帰モデルを用いる場合よりもCIDEr(生成されたテキストの品質を評価する指標の1つ)を4.1ポイント改善しつつ、約2倍となる生成の高速化を達成した。また、文章を包括的に判断しながら生成できる拡散モデルを使うことで、軽量なことを特徴とするJSON形式をはじめ特定のフォーマットに合わせて生成できるようになった。

AIエージェントの活用を加速

パナソニックグループでは現在、AIを活用したビジネス変革「Panasonic Go」を推進しており、2035年までにAI活用事業をグループの売り上げ全体の約30%へ拡大することを目指している。同社はその一環として、AI活用を標準フェーズから、自社データを用いた「特化型・カスタマイズフェーズ」へと移行させている。

特化型のAI活用に向けては、既に同社はストックマークと共同でパナソニックグループ専用の大規模言語モデル(LLM)「Panasonic-LLM-100b」を開発している。これはグループ内の社内データを学習させた1000億パラメータ規模のLLMで、日本語で業務内容の回答が可能であり、ハルシネーションにも強いという特徴がある。

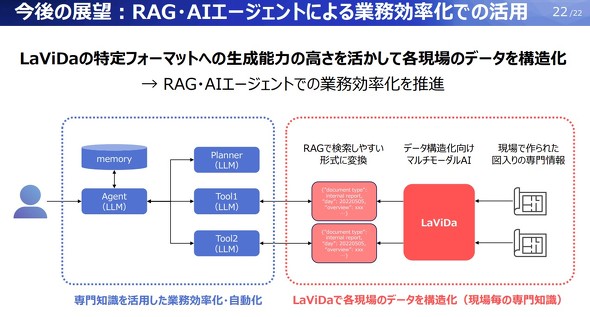

同社は、このPanasonic-LLM-100bに加え、今回開発したLaViDaを社内で活用することで、製造現場などに散在する画像や図面といった「現場ごとの専門知識」の構造化を目指している。具体的には、LaViDaを用いてこれらを読み取り、データベースへ登録可能なテキストデータや、AIシステムが活用しやすい形式へと変換する。現場におけるデータの構造化を通じて、RAGやAIエージェントの適用範囲を広げ、専門知識を活用した全社的な業務効率化を目指す方針だ。

なお、LaViDaは、2025年12月3〜5日に米国サンディエゴで開催される機械学習分野の国際会議「NeurIPS(Neural Information Processing Systems) 2025」に採択された。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

パナソニックが画像認識マルチモーダル基盤を刷新、HIPIEからSegLLMへ

パナソニックが画像認識マルチモーダル基盤を刷新、HIPIEからSegLLMへ

パナソニック ホールディングスはテキストと参照画像を用いて未学習の物体も指示できる対話型セグメンテーション技術を開発した。 AIで勝つ企業へ、パナソニックグループは2035年までにAI関連売上30%を宣言

AIで勝つ企業へ、パナソニックグループは2035年までにAI関連売上30%を宣言

パナソニック ホールディングス グループCEOの楠見雄規氏が、「CES 2025」のオープニングキーノートに登壇した。本稿では、このオープニングキーノートとパナソニックブースの展示内容を前後編に分けて紹介する。 4年目を迎えたパナソニックの「PX」、業務プロセスの変革が着実に進む

4年目を迎えたパナソニックの「PX」、業務プロセスの変革が着実に進む

パナソニックHD 執行役員 グループCIOの玉置肇氏が合同取材に応じ、同氏がけん引役を務める同社のプロジェクト「PX(パナソニックトランスフォーメーション)」の推進状況について説明した。 RAG普及で加速する製造業のナレッジ活用 技術継承への貢献にも期待

RAG普及で加速する製造業のナレッジ活用 技術継承への貢献にも期待

他業種同様、製造業でもRAGの普及が加速している。本記事ではRAGを活用した具体的な事例やサービスなどを参照しつつ、2025年以降にどのような分野での活用が期待されるかや、今後の課題は何かなどざっくりと考えていきたい。 AI活用の障壁であるアノテーションの自動化でパナソニックHDとFastLabelが協業

AI活用の障壁であるアノテーションの自動化でパナソニックHDとFastLabelが協業

パナソニックHDとFastLabelは、パナソニックグループのAI開発の効率化を目的とし協業を行う。AIプロセス全体の効率化とともに、パナソニックHDが開発するマルチモーダル基盤モデル「HIPIE」とFastLabelのData-Centric AIプラットフォームを統合し、自動アノテーションモデルとして構築する。 モノづくりの知識を身に付けた生成AI、パナソニックHDが技術承継などで活用へ

モノづくりの知識を身に付けた生成AI、パナソニックHDが技術承継などで活用へ

パナソニック ホールディングス(パナソニックHD)とストックマークは、パナソニックグループ専用の大規模言語モデルの開発で協業する。パナソニックグループの社内データを追加事前学習させた「Panasonic-LLM-100b」を開発し、設計や製造などのモノづくり業務において、自然言語でのやりとりで業務支援を行えるような仕組み構築に取り組む。