生成AIを軽量化する再構成技術を開発、1ビット量子化でメモリ消費量を94%削減:人工知能ニュース

富士通は、生成AIを軽量化する「生成AI再構成技術」を開発し、大規模言語モデル「Takane」に導入した。1ビット量子化でメモリ消費量を最大94%削減し、精度維持率89%、推論速度3倍を達成した。

富士通は2025年9月8日、生成AI(人工知能)を軽量化する「生成AI再構成技術」を開発し、自社の大規模言語モデル(LLM)「Takane」に導入したと発表した。Cohereのオープンモデル「Command A」を本技術により量子化したモデルをプラットフォーム「Hugging Face」で公開し、2025年10月〜2026年3月期にはTakaneのトライアル提供を開始する。

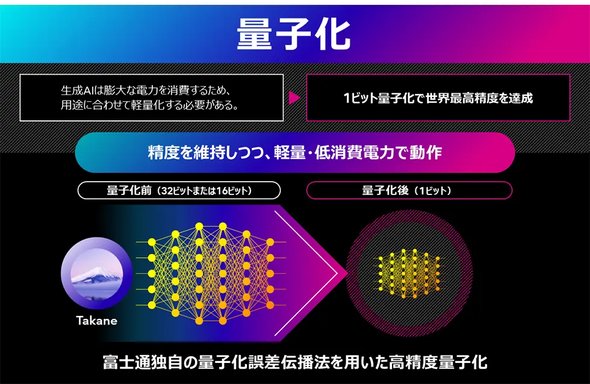

本技術は、従来手法で課題だった量子化誤差の蓄積を防ぐ新アルゴリズムQEP(Quantization Error Propagation)と最適化技術QQA(Quasi-Quantum Annealing)を組み合わせたLLMの1ビット量子化技術および業務特化の知識だけを抽出し軽量かつ高精度のモデルを作る特化型AI蒸留技術で構成されている。

量子化技術をTakaneに適用することで、従来のGPTQ法を大きく上回る精度を確保し、メモリ消費量を最大94%削減しつつ、精度維持率89%と従来比3倍の高速化を達成した。

特化型AI蒸留技術の実証では、商談予測のテキストQAタスクで推論を11倍に高速化しつつ精度を43%向上。画像認識でも未学習物体の検出精度を10%改善した。これにより、GPUコストを70%削減し、従来はGPU4枚が必要なモデルを1枚で稼働できるようになった。また、画像認識タスクにおいて、既存の蒸留技術と比較して未学習の物体に対する検出精度が10%向上した。

本技術の応用により、スマートフォンや工場設備などのエッジデバイス上でも生成AIを効率的に実行できる。リアルタイム性とセキュリティが高まり、省電力運用にもつながる。

今後は、金融や医療など業務特化の軽量AIエージェントを展開し、さらにメモリ消費量を最大1000分の1に削減する研究を進める。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

エッジにも浸透する生成AI、組み込み機器に新たな価値をもたらすか

エッジにも浸透する生成AI、組み込み機器に新たな価値をもたらすか

生成AIが登場して2年以上が経過しエッジへの浸透が始まっている。既にプロセッサやマイコンにおいて「エッジAI」はあって当たり前の機能になっているが、「エッジ生成AI」が視野に入りつつあるのだ。 自動車開発で生成AIはどのように役立つのか、数日かかっていたことを数分に短縮

自動車開発で生成AIはどのように役立つのか、数日かかっていたことを数分に短縮

AWSジャパンは自動車開発における生成AIの活用事例について説明した。 三菱電機が2つの技術でエッジ動作可能なLLMを高精度化、2026年度にも製品適用へ

三菱電機が2つの技術でエッジ動作可能なLLMを高精度化、2026年度にも製品適用へ

三菱電機がエッジデバイスで動作する製造業向け言語モデルを開発。オープンソースのLLM(大規模言語モデル)をベースにエッジデバイスで動作可能とするとともに、タスク正解率をベースモデルの35.8%から約40ポイントの改善となる77.2%に向上した。 シャープがエッジAI「CE-LLM」の展開を加速、「B2BとB2Cで四半期に1つ以上投入」

シャープがエッジAI「CE-LLM」の展開を加速、「B2BとB2Cで四半期に1つ以上投入」

シャープは、2025〜2027年度の中期経営計画(中計)を支えるエッジAI技術「CE(Communication Edge)-LLM」について説明した。 3回目を迎えたマイコンでAIパビリオン、省電力MPUのエッジ生成AIもあるよ!

3回目を迎えたマイコンでAIパビリオン、省電力MPUのエッジ生成AIもあるよ!

「第9回 AI・人工知能EXPO【春】」の「小さく始めるAIパビリオン」に、AIスタートアップのエイシング、インフィニオン、STマイクロ、NXP、ヌヴォトン テクノロジー、ルネサスが出展し、マイコンをはじめ省電力のプロセッサを用いたAI活用に関する展示を披露した。 Armが次世代エッジAIに回答、新プロセッサ「Cortex-A320」に「Ethos-U85」を融合

Armが次世代エッジAIに回答、新プロセッサ「Cortex-A320」に「Ethos-U85」を融合

Armは、エッジ機器での生成AIやトランスフォーマーモデルの推論処理に対応する新たなエッジAIプラットフォームを発表した。Armv9アーキテクチャに基づく省フットプリントの新たなプロセッサコア「Cortex-A320」に、NPUの「Ethos-U85」を組み合わせている。