AMDのザイリンクス買収は「1+1=3」のシナジー、「Ryzen AI」などで大きな成果:人工知能ニュース(1/2 ページ)

米国AMD本社 プレジデントのビクター・ペン氏が来日し同社のAI技術について説明。AMDのCPUやGPU、NPU、FPGAなどの幅広いハードウェア製品や、オープンソースをベースにしたソフトウェアの強みを挙げるとともに、買収したザイリンクスとのシナジーが「Ryzen AI」などで大きな成果を出していることを強調した。

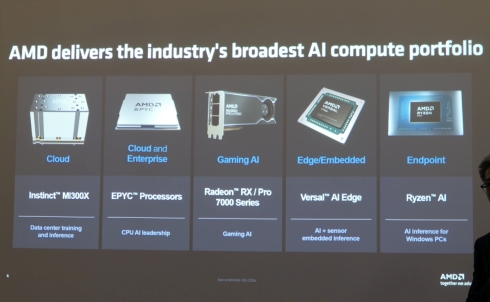

AMDは2024年4月4日、東京都内で会見を開き、来日した米国AMD本社 プレジデントのビクター・ペン(Victor Peng)氏が登壇して同社のAI(人工知能)技術について説明した。ペン氏は「AIによって起こる革新はまだ初期の段階にすぎない。AIは複雑なシステムであり開発するのにハードウェアとソフトウェアの両方が重要な役割を果たすが、AMDはハードウェアとしてCPUやGPU、NPU(Neural Processing Unit)、FPGAなどの幅広いポートフォリオがあり、ソフトウェアについてもオープンソースへの投資を拡充することでエコシステムを強化していく」と強調した。

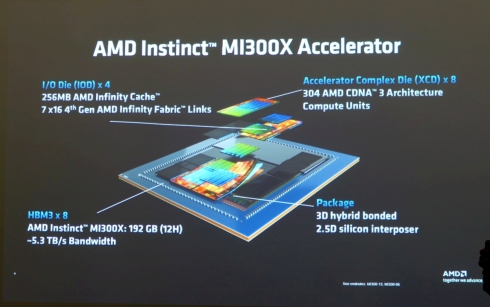

ペン氏の言う通り、AMDはAI処理性能の大幅な向上にフォーカスした製品展開を強化している。例えば、2023年12月に発表したGPUベースのデータセンター向けAIアクセラレータ「Instinct MI300X(MI300X)」は、生成AIの処理性能において競合となるNVIDIAのGPU「H100」を上回る。「生成AIの演算処理を向上するためには、GPUそのものの処理能力を高めるだけでなくデータの不必要な動きを減らす必要がある。そこで、MI300Xでは、GPUとメモリ、キャッシュを高速インタフェースでつなぐとともに、これらの半導体ダイをシングルパッケージに集積して提供することにした。この構成は、生成AI、特にLLM(大規模言語モデル)の処理性能向上に効いてくる」(同氏)という。

実際にMI300Xは、CDNA 3アーキテクチャをベースにしたGPUアクセラレータ複合ダイ(XCD)8個と、総容量256MBとなる高速のLLC(ラストレベルキャッシュ)のダイ4個、総容量192GBとなるHBM3メモリ(最大帯域幅5.3TB/s)のダイ8個をインターポーザ―を介してつなげて1つのパッケージ内に集積している。これを実現できた背景には、AMDと同社が買収したXilinx(ザイリンクス)が持つ3D/2.5Dパッケージ技術がある。

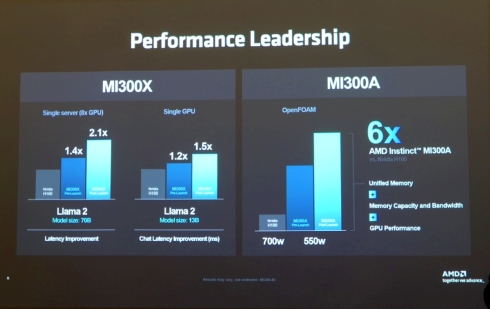

MI300X、そしてMI300XをベースにCPUとGPUを混載するAPUに仕立てた「Instinct MI300A(MI300A)」とも、生成AIの処理性能はNVIDIAのH100を大きく上回る。発表当初はMI300Xが、8GPU構成のシングルサーバでH100の1.4倍、シングルGPUで同1.2倍、MI300Aが同3倍としていた。興味深いのは、発表から3カ月ほど経過した現時点での処理性能が、それぞれ1.4倍から2.1倍、1.2倍から1.5倍、3倍から6倍に向上していることだ。

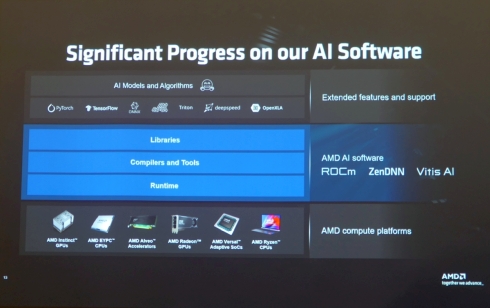

このさらなる性能向上に寄与しているのが、オープンソースを軸に開発を進めるAIソフトウェアだ。AIのモデルやアルゴリズムの開発はPyTorchやTesorFlowに代表されるようにオープンソースが主軸になっており、AMDはこれらの活動をサポートしている。そして、AMDのCPUやGPU、FPGA上でAIモデル/アルゴリズムを動作させるのに必要な、ライブラリやコンパイラ、ランタイムなどから構成されるAIソフトウェアもその多くをオープンソースで公開している。ペン氏は「MI300XとMI300Aの生成AI処理性能が向上したのは、オープンソースベースのエコシステムによってAIソフトウェアの最適化が進んだからだ」と説明する。

Copyright © ITmedia, Inc. All Rights Reserved.