応用範囲を拡大、超低消費電力AI推論アクセラレーターIPの最新版を発表:人工知能ニュース

LeapMindは、超低消費電力AI推論アクセラレーターIP「Efficiera」の最新版「Efficiera v2」を発表した。民生機器、産業機器、ロボットなどさまざまなエッジデバイスへディープラーニング機能を組み込める。

LeapMindは2021年11月30日、超低消費電力AI(人工知能)推論アクセラレーターIP「Efficiera(エフィシエラ)」の最新版「Efficiera v2」を発表した。民生機器、産業機器、ロボットなどさまざまなエッジデバイスへディープラーニング機能を組み込める。同年12月から提供を開始する。

Efficieraは、FPGAデバイス上もしくはASICデバイス上の回路として動作する、CNNの推論演算処理に特化した超低消費電力AI推論アクセラレーターIPだ。

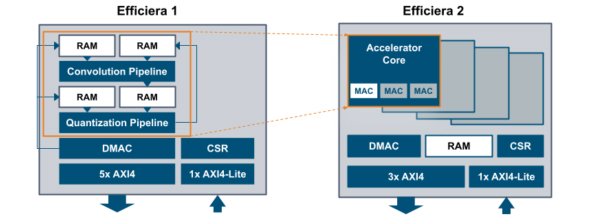

v2では、v1と同様、最小構成の回路規模はそのままに、より広い性能レンジと応用範囲に対応する。MACアレイの多重化とマルチコア化により、性能スケーラビリティを最大48倍に拡大した。

v1でCPUで実行していたSkip connectionは、ハードウェアで実行する。また、Pixel Embeddingもハードウェア化するなど、ハードウェア機能を高めている。外部とのインタフェースには、従来同様AMBA AXIを採用する。

FPGA上の動作周波数はデバイスにもよるが、およそ150〜250MHzを見込む。処理性能は、125MHz(1コア)で256GOP/秒、250MHz(2コア)で最大12TOP/秒としている。

さらに、ユーザーに向けてEfficiera用モデル開発環境(NDK)を提供する。Efficiera用極小量子化DLモデルの作成に必要なコードと情報をパッケージ化しており、GPU用ディープラーニングモデル開発者がすぐに活用できる。DLフレームワークはPyTorchとTensorFlow 2に対応。学習環境はGPU搭載Linuxサーバ、推論環境はEfficiera搭載デバイスとする。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

組み込みAIは必要不可欠な技術へ、推論に加えて学習も視野に

組み込みAIは必要不可欠な技術へ、推論に加えて学習も視野に

2017年初時点では芽吹きつつあった程度の組み込みAI。今や大きな幹にまで成長しつつあり、2019年からは、組み込み機器を開発する上で組み込みAIは当たり前の存在になっていきそうだ。 「Jetson Xavier NX」で組み込みAIを試す

「Jetson Xavier NX」で組み込みAIを試す

2020年5月14日に行われたNVIDIAの「GTC 2020」の基調講演で発売がアナウンスされた、組み込みAIボード「Jetsonシリーズ」の最新製品となる「Jetson Xavier NX」。「Jetson Nano」の連載を担当した技術ライターの大原雄介氏に、Jetson Xavier NXの開発者キットをレビューしてもらった。 低コストFPGAで深層学習、コア技術をオープンソース化したベンチャーの狙い

低コストFPGAで深層学習、コア技術をオープンソース化したベンチャーの狙い

LeapMindは2018年10月19日、組み込み向けFPGA上でディープラーニングを動作させるソフトウェアスタックをオープンソースで公開した。同社が今まで強みとしてきた技術が、誰でも利用もできるようになった。同社CTO(最高技術責任者)を務める徳永拓之氏に、blueoilとはどのようなもので、何が実現できるのか。そして、オープンソース化した狙いなどを聞いた。 エッジAIは専用プロセッサの流れに、LeapMindが独自IPの設計を明かす

エッジAIは専用プロセッサの流れに、LeapMindが独自IPの設計を明かす

LeapMindはディープラーニングの推論処理に特化した低消費電力プロセッサIP(Intellectual Property)の開発を明らかにした。 オープンソースソフトウェアスタックを高速化するハード設計をリリース

オープンソースソフトウェアスタックを高速化するハード設計をリリース

LeapMindは、オープンソースソフトウェアスタック「Blueoil」向けに高速化した新たなハードウェアアクセラレータ設計をリリースする。 「Cyclone V SoC」上で高い推論精度を発揮するディープラーニング技術

「Cyclone V SoC」上で高い推論精度を発揮するディープラーニング技術

LeapMindは、SoC FPGAを使用したディープラーニングの顔検出で、推論スピード10.5fpsの性能を達成した。低消費電力のSoC FPGA上に、推論精度を低下させずに物体検出機能を実装できることが確認できた。