ルネサスが新たなエッジAI技術を開発、世界最高クラスの電力効率と推論精度:人工知能ニュース(1/4 ページ)

ルネサス エレクトロニクスは2019年6月13日、低消費電力で高速にCNN(畳み込みニューラルネットワーク)の推論を実行できるAI(人工知能)アクセラレータ技術を開発したと発表した。同技術を用いたテストチップは高い推論精度を維持しつつ、世界最高クラス(同社調べ)となる8.8TOPS/Wの電力効率を実現した。

ルネサス エレクトロニクス(以下、ルネサス)は2019年6月13日、低消費電力で高速にCNN(畳み込みニューラルネットワーク)の推論を実行できるAI(人工知能)アクセラレータ技術を開発したと発表した。同技術を用いたテストチップは高い推論精度を維持しつつ、世界最高クラス(同社調べ)となる8.8TOPS/Wの電力効率を実現。同社の組み込みAIソリューション「e-AI」で2022年以降にリリースする次世代製品から同技術が応用される見込みだ。

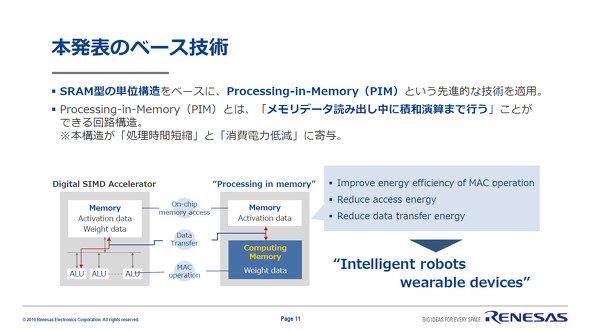

ルネサスが今回開発したAIアクセラレータ技術は、ランダムアクセスメモリの回路に演算器を内包させる「Processing-in-Memory(PIM)」アーキテクチャをベースとしている。PCやサーバ、組み込み機器などで用いられている一般的な計算機アーキテクチャは演算器とメモリが分離している。これにより命令フェッチやメモリアクセスにおいて相互のデータ転送が必要で、処理の遅延要因となっている。

一方で、昨今注目を集めるPIMはメモリデータ読み出し中に積和演算を同時実行できるため、メモリアクセスの遅延を解消するとともにメモリアクセスによる消費電力も削減できる。このようなPIMのメリットを生かし、機械学習用アクセラレータを開発した既報の研究も数件みられる。

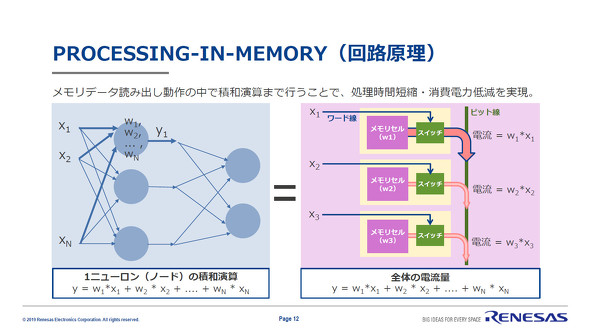

PIMによる積和演算の実行

ニューラルネットワークの推論処理では、ウェイト(重み係数)とアクティベーション(入力)の積和演算を多用する。SRAM(Static Random Access Memory)によるPIMでニューラルネットワークの積和演算を実行する場合、SRAMの各メモリセルには1ビットのウェイトが保存されており、“High”もしくは“Low”の状態を取るワード線電位が1ビットのアクティベーションに対応する。メモリセルを読み出す動作でウェイトとアクティベーションの積が電流値として演算され、メモリセルアレイを読み出すことで各SRAMセルから出力された電流値の合計、すなわち積和演算結果を得ることができる。

しかしながらこの従来手法は、ウェイトとアクティベーションを2値化した量子化ニューラルネットワークの処理となるため、アプリケーションによっては推論精度に影響が出る。また、SRAMの製造プロセスのばらつきが演算精度を低下させる要因ともなるため、製造プロセスのばらつきを回避する技術が必要となっていた。

Copyright © ITmedia, Inc. All Rights Reserved.