自動車が目新しくない「CES 2018」は「ビジョン」から「ビジネス」の段階へ:次世代モビリティの行方(1)(2/3 ページ)

これまでスタンドアロンな存在だった自動車は、自動運転技術の導入や通信技術でつながることによって新たな「次世代モビリティ」となりつつある。本連載では、「CES」や「Mobile World Congress」などの海外イベントを通して、次世代モビリティの行方を探っていく。第1回は「CES 2018」の自動車関連の動向をレポートする。

自動車における安全性の追求

自動車領域におけるIT活用の大きな目的の1つとして挙げられるのが、安全性の確保/追求である。死亡事故撲滅は自動車業界が抱える大きな課題の1つであり、そのためのさまざまな運転支援技術やサービスがこれまでも発表されてきている。

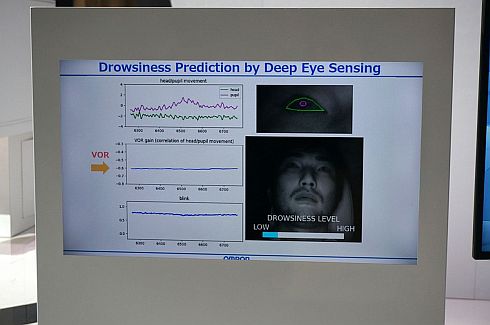

代表的なものが、画像認識による疲労度測定だ。CES 2018でも、NVIDIAやオムロンなどが目や表情の動きを計測トラッキングして疲労度を把握し、安全運転を促すソリューションを展示していた他、中国の検索大手百度(Baidu)も、視線を前方からそらすと、「前を見なさい」と車内中に注意喚起が響き渡るソリューションを紹介していた。

ここ数年、このような画像認識によるドライバーモニタリングが注目されているが、CES 2018で新たに着目されたのが「脳」と「5G活用」だ。

日産「Brain To Vehicle(B2V)」:運転支援に脳波を活用

日産自動車はCES 2018において、未来の安全技術の姿を披露した。それが「Brain To Vehicle(B2V)」技術である。

ドライバーにヘッドセット型デバイスを装着し、脳波を測定/解析することで運転を支援するというものだ。同技術は人間による運転時とクルマが自ら操作する自動運転時の両方に対応しているという。具体的には、ドライバーが運転動作を行う前に生じる「行動準備電位」と、理想と異なる運転が行われた時に生じる「エラー関連電位」を測定/解析することにより、人間による運転時にはドライバーが行おうとしている操作を先取りして実行することで遅れによる事故を防ぎ、自動運転時にはドライバーの不安を解消する運転操作をクルマが行うことで安全性を確保するのが狙いだ。個々人の脳波の傾向を学習するのに相応の時間を要することもあり、実用化はまだ先の模様である。

CESでは長年、脳波に注目した技術開発が行われてきた。過去には、ミューズ(Muse)が脳波を測定して感情コントロールを訓練するデバイスとソフトウェアを紹介し、ハイアール(Haier)は脳波によりテレビをコントロールするソリューションを展示したことがある。2018年は、ロシアのニューロトレンド(Neurotrend)が脳疾患などにより言葉や身体の自由を失った人たち向けに、脳波を活用して文字入力をし、メッセージを送信できる技術「NeuroChat」を紹介していた。

脳波の活用にはまだまだ時間がかかるものの、有力なインタフェースの1つとして期待されている。その領域に日産自動車という大企業が乗り出したという意味で注目といえるだろう。

iNAGO「netpeople」:ドライバーの脳の疲労度を考慮した情報提供を実現

カナダに拠点を置くイナゴ(iNAGO)は、自然対話型のアシスタントプラットフォーム「netpeople」を活用した「Intelligent Driver Assistant」を披露した。アマゾンのAlexaや「Google Assistant」などの音声認識AIがCESの話題をさらう中、実はイナゴは両社よりも前から、音声認識AIによるエコシステムの構築を行っている。

Intelligent Driver Assistantは、まるで同乗者がドライバーを気遣うように情報提供を行う安全支援システムだ。音声インタフェースには、同社が提供する音声対話アプリ「mia」を活用する。Miaは、電話やSMSの着信から情報検索までアップルの「Siri」などと同様の機能を有する。

ただし、同システムがSiriなどと異なるのは、運転時のドライバーの脳の疲労度(Cognitive Workload)を計算しながら会話をコントロールする点だ。例えば、交差点や右左折時、歩行者が多い時など、集中力を要する場面では同乗者がドライバーに話しかけるのをやめるのと同様、音声エージェントもドライバーへの情報提供を制限し、適切なタイミングになるまで情報をプールする。

これらの一連の判断は、カーナビゲーションやCANバスから収集したデータをシステムがクラウドに送信し、クラウド上で脳の負荷を計算することで実現する。しかし例えば、エンジントラブルなど緊急を要する場合は、たとえ脳に負荷が掛かっていると判断した場合でも情報提供を行う。つまり、ドライバーの疲労度を勘案した上で、必要な情報は提供する一方、重要でないと判断したものについては後回しにするのである。運転中のドライバーの安全と利便性の向上の両方を追求したシステムといえる。

現時点ではフィジカルな情報を活用はしておらず、さまざまなデータを基にルールを設定し、その時々の環境に応じた注意喚起や情報提供をしてくれる。ルールベースで実施している理由としてイナゴは「膨大な量の良質なデータがあれば機械学習で処理させる方が有益だが、データが十分といえない段階ではルールベースのほうがより安全性を確保できる」としている。次世代バージョンにおいて、アイトラッキングなど他のデータを統合し、さまざまな角度からドライバーの疲労度合いを把握する運転アシスト技術の開発を目指すとのことだ。

その他イナゴは「Knowledge Assistant」と呼ぶ、会話型カーマニュアルも提供している。通常、車両にトラブルが発生した際に、ダッシュボードなどにアイコンが点灯して異常を知らせるが、そもそもそのアイコンの意味が理解できないケースが多い。また、アイコンからマニュアルを調べるのも至難の業である。

そのような課題を解決するために、音声を活用してQ&A形式でアイコンの特徴を伝え、異常の原因を把握し、即座の対応が必要かどうかも含め教えてくれるというものだ。現時点で対応している言語は英語のみ。今後、日本語などの他言語にも対応していく予定だとしている。同システムは、クルマに限らず他産業のマニュアルにも対応可能としている。

Copyright © ITmedia, Inc. All Rights Reserved.