東工大のスパコン「TSUBAME」の将来像とは――遠藤教授&野村准教授に聞く:AIとの融合で進化するスパコンの現在地(2)(2/3 ページ)

急速に進化するAI技術との融合により変わりつつあるスーパーコンピュータの現在地を、大学などの公的機関を中心とした最先端のシステムから探る本連載。第2回は、東京工業大学の「TSUBAME 4.0」の構築と運営を担当している同大学 教授の遠藤敏夫氏と准教授の野村哲弘氏のインタビューをお届けする。

x86 CPUを必要とする研究も重視しつつ仕様を固める

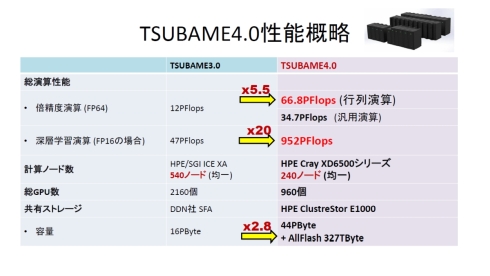

――TSUBAME 3.0とTSUBAME 4.0の性能比較によると、行列演算性能(FP64)で5.5倍、深層学習性能(FP16)で20倍とあります。一方で計算ノード数は540から240に減っていますね(図3)。こういった性能バランスはどう考えたのですか?

野村 TSUBAME 3.0の利用状況の他、各社のハードウェアの進化の動向も見ながら、予算の制約の中でどのあたりに着地させるかを考えていきました。性能に関してはプロセッサベンダー各社のロードマップに依るところが大きく、後は全体の予算や電力的な予算との兼ね合いで、最終的に240台でシステムを構成しています。

遠藤 どうしてもAI性能に注目が集まりがちなんですけど、TSUBAMEのユーザーにはx86 CPUで動作する商用アプリケーションを利用してCAEのようなシミュレーションなどの研究を行っている方も多数います。ですから入札仕様には、既存のアプリケーションを動かすために何%以上のノードでx86命令が使えること、といった要件を設定しました。

――Armのプロセッサコアを統合したNVIDIA GH200 Grace Hopper Superchipを採用しなかったのはそのためなんですね。

東京工業大学 学術国際情報センター 准教授の野村哲弘氏。TSUBAME 2.0が稼働していた2011年に着任。TSUBAMEのリソースの分割やブラウザベースでのジョブ投入などを開発するなど、運用面を中心に幅広く担当 撮影:関行宏

野村 一部のノードにせよ落札ベンダーがGrace Hopperを選ばなかった理由は応札者の判断なのでわれわれには正確には分からないところではありますが、x86をメインにして一部にGrace Hopperを入れるとヘテロジニアスなシステムになってしまうので、それを嫌った可能性が高いかなと思っています。

――TSUBAME 4.0の設計ではどのような難しさがありましたか。

野村 システムの影も形もない状態で、建屋や電力系統や冷却方法を決めていくのが大変でした。最大消費電力や運用中の定常値が設備の容量や電力契約に関わってきますし、とはいえ実際に動かしてみないと分からないこともあって、しかも入札仕様として文書化しなければいけないところにかなり苦労しました。電力に関しては2MWの電力線を引いて、3相4線式415Vから単相240Vを作って各ノードに供給しています。

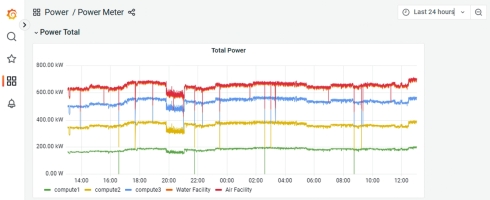

遠藤 すずかけ台キャンパス全体でおよそ6MWの電力を消費していて、TSUBAME 4.0は定常時で0.6MWから0.7MW程度ですので、キャンパス全体の10分の1くらいですね(図4)。冷却に関しては、TSUBAME 3.0からの継続で、CPUとGPUは水冷で、その他は空冷のハイブリッド式にしています(図5)。

Copyright © ITmedia, Inc. All Rights Reserved.