AIが判断した根拠を一般ユーザーにも分かるように明示、三菱電機と理研が新技術:人工知能ニュース(1/2 ページ)

三菱電機が理化学研究所と共同で「制御の根拠を明示できるAI技術」を開発。今回開発したAI技術によって、AIが判断した制御の根拠や将来の状態を明示することでいわゆる「ブラックボックス問題」を解消し、人が理解しやすいAIの実現に貢献できる。今後は、5年以内となる2026年をめどに製品への搭載による実用化を目指すとしている。

三菱電機は2021年12月14日、オンラインで会見を開き、理化学研究所と共同で「制御の根拠を明示できるAI技術」を開発したと発表した。機械学習や深層学習など、近年の進化が著しいAI(人工知能)技術は、計算が複雑で推論過程がブラックボックスとなるため、人が理解しづらく、信頼性や説明性が求められる制御分野に適用する上で大きな課題になっていた。今回開発したAI技術によって、AIが判断した制御の根拠や将来の状態を明示することでブラックボックス問題を解消し、人が理解しやすいAIの実現に貢献できる。今後は、5年以内となる2026年をめどに製品への搭載による実用化を目指すとしている。

同社は2017年から「Maisart」のブランド名称で、機器やエッジをスマート化するAI技術の開発に注力している。これまでにAI関連で56件の広報発表を行っており、うち2021年度に発表したのは5件で、今回の「制御の根拠を明示できるAI技術」はその最新の成果となる。三菱電機 情報技術総合研究所長の楠和浩氏は「今後AIと人が密接に関わっていく世の中が到来することは確実だろう。そこで、人とAIの親和性につながる、協調性、説明性などが重要なテーマになる。今回の開発技術は、その一助となるものだ」と語る。

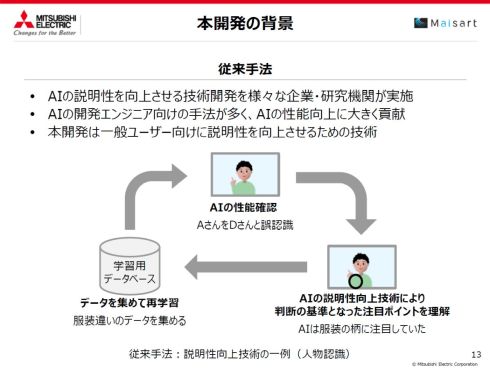

AIの開発に携わる技術者向けだった、AIの説明性向上技術

機械学習や深層学習などAIのブラックボックス問題に対しては、その説明性を向上する技術の開発をさまざまな企業や研究機関が行っている。ただし、これらの技術はAIの開発に携わる技術者向けであり、AIを活用したアプリケーションを利用する一般ユーザー向けのものにはなっていない。

三菱電機 情報技術総合研究所 知能情報処理技術部長の杉本和夫氏は「例えば、画像を用いた人物認識のAIを開発で誤認識が発生した場合に、AIの説明性向上技術が判断の基準となった画像の注目ポイントを示してくれるので、適切な学習データの収集による再学習で効率よくAIの認識精度を向上できるようになる。しかし、これはAI開発技術者にとっての説明性の向上であり、今後広くAIを活用することになる一般ユーザーにとっての説明性の向上にはなっていなかった。今回開発したAI技術は、今までできていなかった、一般ユーザーに対する説明性の向上を目指すものだ」と述べる。

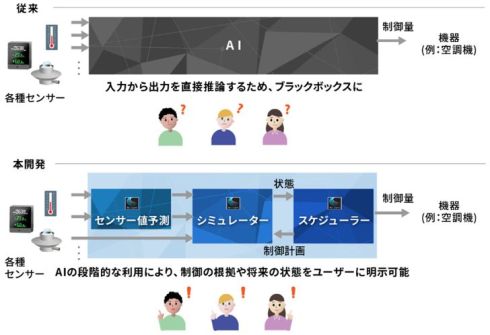

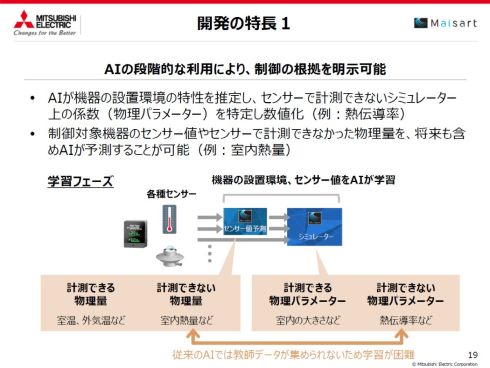

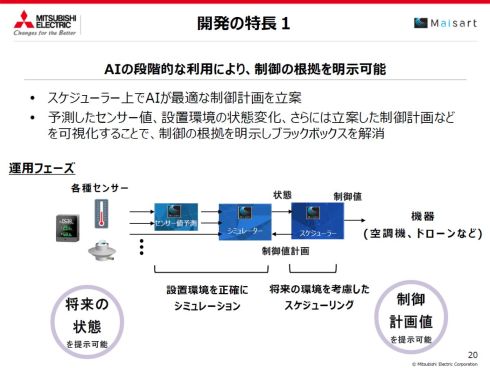

開発したAI技術は3つのモジュールから構成されている。1つ目のモジュールは、各種センサー値を入力として学習してセンサー値の予測を行う「センサー値予測」である。2つ目のモジュールは、センサー値から計測可能な機器の設置環境などと関わる係数となる物理パラメーターを推定するとともに、センサーで直接計測できない係数となる物理パラメーターを特定し数値化する「シミュレーター」になる。このシミュレーターによって、これまで計測できなかった物理パラメーターを特定できるようになり、センサーで計測できなかった物理量の計測や予測も可能になるという。

そして3つ目のモジュールが、センサー値予測とシミュレーターの両モジュールから導き出された設置環境の正確なシミュレーション結果を基にして制御計画を立案する「スケジューラ―」である。これら3つのモジュールで構成されるAIの段階的な利用によって、予測したセンサー値、設置環境の状態変化、AIが立案した制御計画が可視化されるので、制御の根拠が明示されてブラックボックス問題を解消できるという仕組みだ。

Copyright © ITmedia, Inc. All Rights Reserved.