企業が「責任あるAI」を実現するための4つのアプローチ:人工知能ニュース(1/2 ページ)

アクセンチュアは2021年8月25日、AI設計や活用において企業の社会的責任をいかにして実現するかという、「責任あるAI」をテーマとしたセミナーを開催した。セミナーでは企業が社会的責任を実現するための、4つの具体的なアプローチ方法を紹介した。

アクセンチュアは2021年8月25日、AI(人工知能)設計や活用において企業の社会的責任をいかにして実現するかという、「責任あるAI」をテーマとしたセミナーを開催した。セミナーでは企業が社会的責任を実現するための、4つの具体的なアプローチ方法を紹介した。

AI設計、展開の透明性と公平性を確保

アクセンチュアは「責任あるAI」について、企業によるAIの設計や展開において、顧客や社会に対して、いかにして公平性や透明性を担保するかを示す方法論と定義する。

現在、AIの研究開発は急速に進み、性能を向上させている。これと共にAIサービス/プロダクト市場も大きく拡大しつつあり、幅広い領域でAIが人間の意思決定を支援するようになっている。

だが、これはAIが社会に及ぼす影響力が以前より増しているということでもある。AI開発においては訓練データの用意に始まり、モデルの訓練や評価、学習アルゴリズム開発、パラメータ調整、出力結果の解釈に至るまで人間の意思決定が介在する。このため、開発過程のいずれかで人間が持つバイアス(偏見)を学習、増幅する危険性がある。例えば、クレジットカード会社が算出する信用スコアにおいて男女間に差が生まれる、顔認証によるリスク推定が人種間で異なる結果になるなど、人間が持つ社会的偏見が強化されかねないケースが想定される。この他にも、サンプリングバイアスや確証バイアスがAIによって増幅され、問題のある結果を生み出す危険性もある。

AI倫理を実現する4つのアプローチ

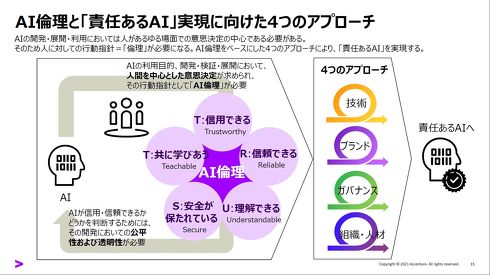

企業によるAIの取り組み全般において、こうした潜在的リスクへの対策は必要である。アクセンチュア AIグループ シニア・マネジャー 鈴木博和氏は、「責任あるAI」の実現には、その開発指針として「信用できる(Trustworthy)」「信頼できる(Reliable)」「理解できる(Understandable)」「安全が保たれている(Secure)」「共に学びあう(Teachable)」の頭文字をとった「TRUST」を基軸とするAI倫理を定める必要があると指摘した。また、TRUSTを実現するための具体的なアプローチとしては、「技術」「ブランド」「ガバナンス」「組織・人材」の4つが存在すると説明した。

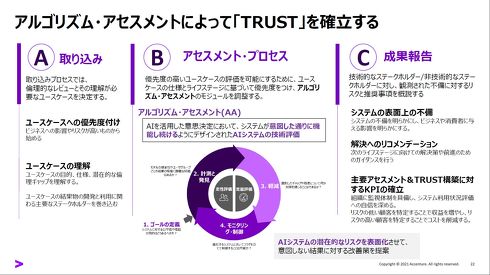

「技術」では、主に技術的な手法によって行われるアルゴリズムのアセスメント(評価)を主眼に置く。評価手法は、定量的なものではAIの性能評価や透明性や公平性を数値的に評価する、定性的なものではAI開発に関わるステークホルダー全体に聞き取りなどを行い、問題点を明確化する、というものがそれぞれ考えられる。これらの取り組みを通じてAIシステムの潜在的なリスクを顕在化させて、意図しない結果の発生を防ぐ。

Copyright © ITmedia, Inc. All Rights Reserved.