クラウド化をためらわない協和キリン、高崎工場のDXは1年半で大きな成果:モノづくり最前線レポート(2/3 ページ)

アマゾン ウェブ サービス(AWS)のオンラインユーザーイベント「AWS Summit Online」に、協和キリンが登壇。「ライフサイエンス業界の規制に対応したクラウド活用最前線」をテーマに、全社ITシステムのクラウド化推進や、主力の高崎工場におけるデジタル化プロジェクトの成果について報告した。

クラウドベースのDataHubを導入、Excelによる手作業の負担を大幅軽減

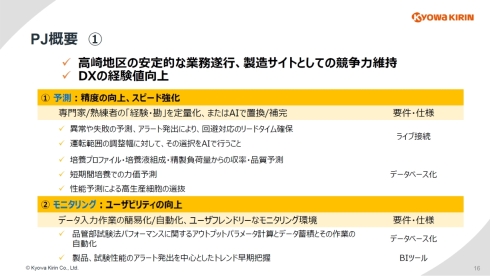

高崎デジタル化PJでは、高崎地区の安定的な業務遂行や製造サイトとしての競争力維持、DXの経験値向上を目的として「予測」と「モニタリング」をテーマにした2つの取り組みを行っている。同プロジェクトをとりまとめている武内氏は「ICTの領域は進化が早く、必要になったと感じたときに取り組み初めても遅いという印象がある。周回遅れにならないよう、DXに参戦しておく必要があると考えた」と語る。

「予測」では、専門家/熟練者の「経験、勘」の定量化やAIによる置換と補完による精度の向上、スピード強化を目指している。一方、「モニタリング」は、データ入力作業の簡易化と自動化や、ユーザーフレンドリーなモニタリング環境の提供によるユーザビリティの向上が目的となっている。

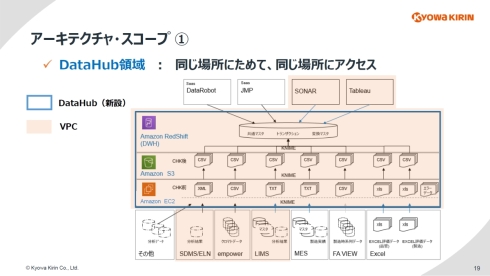

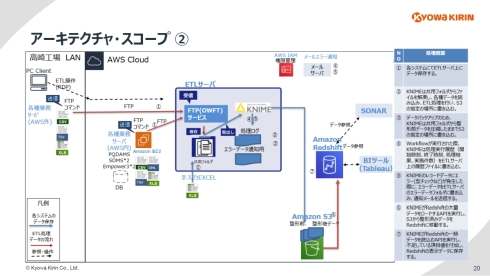

これらの取り組みで重要な役割を果たすデータ活用のハブシステム(DataHub)の構築で採用したのがAWSだ。ETL(Extract/Transform/Load)、データレイク、DWH(データウェアハウス)を含めたフルマネージドサービスによる構成が可能であること、サポートベンダーについて複数の選択肢があること、協和キリン社内におけるAWSサービスの高い利用実績があること、AWSのGxP対応の意識などが採用理由になる。

DataHubは「同じ場所にためて、同じ場所にアクセスする」(武内氏)をコンセプトに構築された。ETLには研究開発分野で広く利用されているデータ連携・統合・分析プラットフォームの「KNIME」を、データレイクは「Amazon S3」、DWHは「Amazon RedShift」を用いている。このDataHubとつながる各種システムも、AWSのVPC(Virtual Private Cloud)内に組み込まれている。

このDataHubへのデータの流れとしては、まずAWS外の各種業務サーバ上にあるCSVやTSV、Excelなどの帳票ファイルをFTPツールなどによってETLサーバにデータ保存すると、KNIMEがETL処理を行ってS3の指定の場所に書き込む。KNIMEはデータのバックアップや、処理ログの保存、エラーデータの通知など、管理者のバックアップ的な機能も果たしている。S3から整形済みデータをRedShiftに移動した後は、データベースにデータが書き直される。そして、RedShiftと、BIツールとなる「Tableau」と「SONAR」が連携することで、さまざまなデータの見える化が可能になるわけだ。

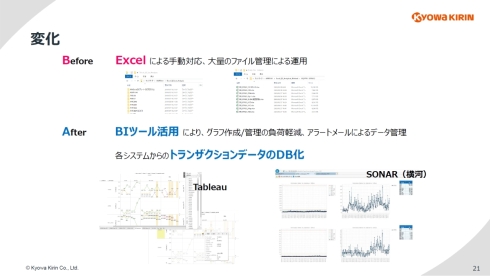

クラウドベースのDataHubを実現することにより、ユーザー側には大きな変化が起こった。従来は、大量のExcelファイルを使ってのデータ入力からグラフの作成/管理までさまざまな業務を手動で対応する必要があった。しかし、DataHubの導入後は、BIツールであるTableauとSONARによってグラフの作成/管理が不要になり、品質試験で閾値を超えた場合のアラートもメールで通知できるなどさまざまな業務負担の軽減が可能になった。「もちろん、各システムのトランザクションデータも自動でDB化されるので、今後のデータ活用に向けた基盤が整った」(武内氏)という。

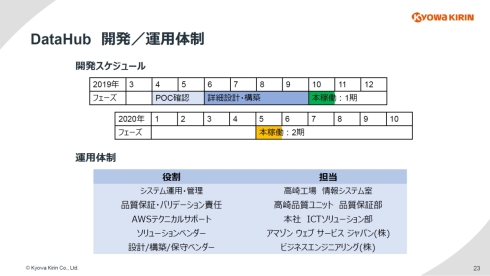

これら高崎デジタル化PJの取り組みは、2019年4月から半年の開発期間を経て同年10月から本稼働を開始している。2020年5月からは、MES(製造実行システム)やLIMS(ラボ情報管理システム)など各種システムのトランザクションデータとの自動連携機能も加わった。

Copyright © ITmedia, Inc. All Rights Reserved.