4K・8K映像とインタラクティブ性の融合が製造業にもたらす新たな世界:4K・8K映像基礎解説(2/3 ページ)

2018年12月に国内で4K・8K放送がスタートし、本格的な高解像度のテレビ放送の時代が始まった。本稿では、この4K・8K映像という新しい技術の概要や、インタラクティブ性との融合によって製造業にもたらされるであろう2020年代の新たな世界について解説する。

2.映像技術とインタラクティブ性

映像技術の進化とともに、高解像度の映像を見るだけでなく、映像を見ながら対話するように操作をするインタラクティブ性に対応した技術も求められるようになりました。このインタラクティブ性をいち早く実現し、実用化したのはビデオゲーム分野です。

1970年代、米国のアタリ(Atari)が世界で初めて商用のビデオゲームとして成功した「PONG(ポン)」は、卓球台を上から見た映像上で2人のプレーヤーがピンポン玉を打ち合うという内容でした。ラケットは縦方向にしか動かすことができませんでしたが、自分の操作が映像内にリアルタイムで反映され、実際に対戦することも可能でした。

1980年にナムコ(現バンダイナムコエンターテインメント)が開発した「パックマン」は、初めてAI(人工知能)の原理をゲームに搭載したといわれています※2)。敵(コンピュータ)から逃げる操作だけでなく、プレーヤーがアイテムを取得すると敵を追いかけて捕まえるという操作の切り替えが発生するゲームでした。ゲームの敵が知能を持ったかのように動く形式は真新しく、全世界で爆発的にヒットしました。

※2)人工知能学会「人工知能」Vol.34, No.1(2019年1月号)アーティクルより

ビデオゲームはインタラクティブ性が大変重要です。例えばドライビングのゲームやシミュレーターでは、ハンドルやアクセル、ブレーキの操作を瞬時に映像に反映させる必要があります。これはゲームの良さを判断する材料の1つであり、格闘ゲームやパズルゲーム、シューティングゲームなども同様です。ビデオゲーム世代は、このインタラクティブ性がもたらす感覚を五感のように身に付けているものと考えます。

そして今、ビデオゲームは大ブームが再来するといわれています。その背景にあるのは「eスポーツ」の出現です。2018年夏にインドネシアで開催された第18回アジア競技大会では、eスポーツがデモンストレーション競技として採用されました※3)。アジア圏には多数のeスポーツ先進国(地域)があります。台湾では、日本の文部科学省にあたる教育部体育署にeスポーツ部門が開設され、eスポーツのスポンサーになった企業に対して税金を軽減するなど、政府によるeスポーツ普及のための取り組みが行われています。日本でもビデオゲームの見本市でeスポーツの大会が開催され、民間放送でeスポーツの番組が始まるなど、徐々に広まりつつあります。

※3)第18回アジア競技大会のジャカルタ・パレンバンのデモンストレーション競技として採用されたeスポーツ「ウイニングイレブン2018」では、日本代表ペアが金メダルを獲得しました。

今後はeスポーツのためのビデオゲームの開発も進むと思われ、それはいち早く高解像度映像技術とインタラクティブ性の融合が実用化される分野であると考えます。

3.高解像度映像を導く新しい技術

ここまで、映像技術の進歩とインタラクティブ性の実現によって、スポーツやビデオゲームの世界で変革が起きたということを説明しました。今後は、これらの高解像度映像技術が、産業、医療、自動車分野にも利用されていくと予想されています。それには、以下に挙げる4つの技術的なファクターがあると考えます。

①通信インフラ整備の発展

通信インフラには光ケーブル(有線)と次世代通信(無線)が求められます。光ケーブルは、最近のインターネットサービスで利用されて、テレビ放送やインターネットによる映像配信が行われています。次世代移動通信方式である5Gは2020年に導入が予定されていて、現在の4Gの約100倍の転送速度を実現できます。高解像度映像を配信できる通信手段となるため、5Gを提供予定の通信各社は高解像度映像を利用したさまざまな実証実験を行っています。

②コーデック技術の進化

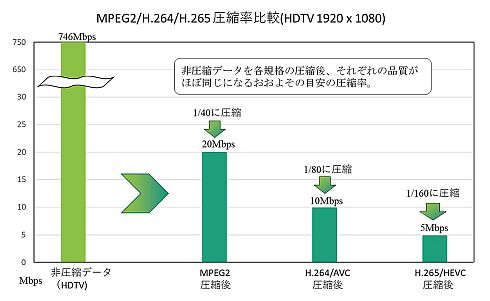

以前のテレビはアナログ放送で、放送方式は日本や北米でのNTSC方式と欧州地域のPAL方式がありました。現在の地上波放送、BS/CS放送は2K(1080i)と呼ばれるデジタル放送です。日本では、地上波放送、BS/CS放送にMPEG規格の「MPEG-2」と呼ばれる動画像圧縮符号化の技術を使用しています。MPEG-2は、圧縮していないデータ(RAWデータ)からの圧縮率は12分の1〜50分の1で、2K映像を10M〜30Mbpsの転送レートに抑えることが可能です。しかし、MPEG-2規格で取り扱うことができる解像度は、2K相当(横1920×縦1152画素)までしか規定されていませんでした。

2003年、H.264というMPEG規格のコーデック技術が現れました。これは、MPEG-2と同じ映像品質に圧縮した場合、約半分のデータ量に圧縮することができ、4Kの解像度にも対応できるようになりました。技術的には、圧縮といっても単純に映像を圧縮するだけでなく、前の画像から変化があった部分の情報のみを持つという仕組みです。

さらに、現在の日本の4K放送では、H.265というコーデック技術を使っています。一般的にH.265は、H.264と同じ映像品質を圧縮した場合の約半分のデータ量に圧縮可能といわれており、効率的に高解像度映像を配信することができるようになりました。つまり、MPEG-2と比較するとH.265では4分の1のデータ量に圧縮可能ということになります。

③低遅延の実現(インタラクティブ性の実現)

映像を圧縮(エンコード:符号化)して送信するとデータ量が減り、通信インフラの負荷を削減できますが、受信側では解凍(デコード:復号)が必要です。エンコードおよびデコードに時間がかかってしまうと、インタラクティブ性を低下させるタイムラグを引き起こす原因となります。高圧縮する技術とともに、遅延がほぼ無いエンコード、デコード技術の実現が重要です。

④半導体のさらなる高集積化

高解像度映像に対する処理はデータ量も大幅に増えるため、FPGAやASICなどの半導体のリソースを多く使用します。特にコーデック処理では、8Kは4Kの4倍のリソースが必要とになります。コーデック技術の進化によって、必要なリソースも増大しており、例えばH.265はH.264の1.5〜1.6倍に達するといわれています。そのため、半導体の高集積化の進歩も重要なファクターとなります。

Copyright © ITmedia, Inc. All Rights Reserved.